AI wciąż w ślepym zaułku? Mijają kolejne lata, a LeCun nie zmienia zdania.

🤖 Gemsy i Gemini Advanced na 12 miesięcy w cenie urządzenia

🔉Wolisz wersję audio? Nie możesz przeczytać teraz maila?

Przesłuchaj tutaj

Możesz nas słuchać także na Apple Podcast i Spotify.

🎯W DZISIEJSZYM WYDANIU

🎓 AI od zera do zrozumienia: AI wciąż w ślepym zaułku?

🛠 AI w praktyce: 🤖 Gemsy i Gemini Advanced na 12 miesięcy w cenie urządzenia

🥡 AI na Wynos:

📲 Pierwszy AI telefon

🤑 Wygrali na loterii korzystając z AI

🇵🇱 PLLuM już zaciągnięty do pracy w dużej polskiej firmie

🤯 Broń nuklearna zarządzana przez AI

🩺 WHO sięga po AI

🗣 Amazon Prime testuje dubbing AI

🚁 Drony i AI w polskiej armii

🎚 Szybciej-Wolniej. Nowa opcja w ElevenLabs.

🔍 Nowa przeglądarka AI.

📚 Rekomendowana Biblioteka:

Demis Hassabis: Droga do AGI

Model JEPA - alternatywa dla skalowania LLM

W Horyzont AI już od prawie dwóch lat regularnie przywołujemy postać Yanna LeCuna, jednego z najważniejszych naukowców w świecie sztucznej inteligencji. Być może pamiętacie moje wcześniejsze analizy jego poglądów, czy to w postach na X, czy w poprzednich wydaniach Horyzont AI. LeCun to postać, która nie boi się mówić rzeczy kontrowersyjnych, kwestionując nie tylko obecny stan AI, ale i całą trajektorię, w jaką wchodzi branża.

W ubiegłym tygodniu na kanale This is IT prowadzonym przez Macieja Kaweckiego pojawił się obszerny wywiad z LeCunem, w którym po raz kolejny dał jasno do zrozumienia: AI zmierza w niewłaściwym kierunku, a duże modele językowe nie są rozwiązaniem problemu inteligencji. Ponieważ temat ten przewija się w naszych rozmowach regularnie, postanowiłem pochylić się nad jego twierdzeniami raz jeszcze – tym razem pod kątem najważniejszych wniosków z tego konkretnego wywiadu. Jeśli nie mieliście czasu go obejrzeć, oto najważniejsze punkty, analiza i kontekst, które pomogą Wam zrozumieć, co LeCun naprawdę myśli o przyszłości AI i dlaczego nie zamierza zmieniać swojego stanowiska.

Czy rzeczywiście AI znalazło się w ślepym zaułku ?

Kim jest Yann LeCun?

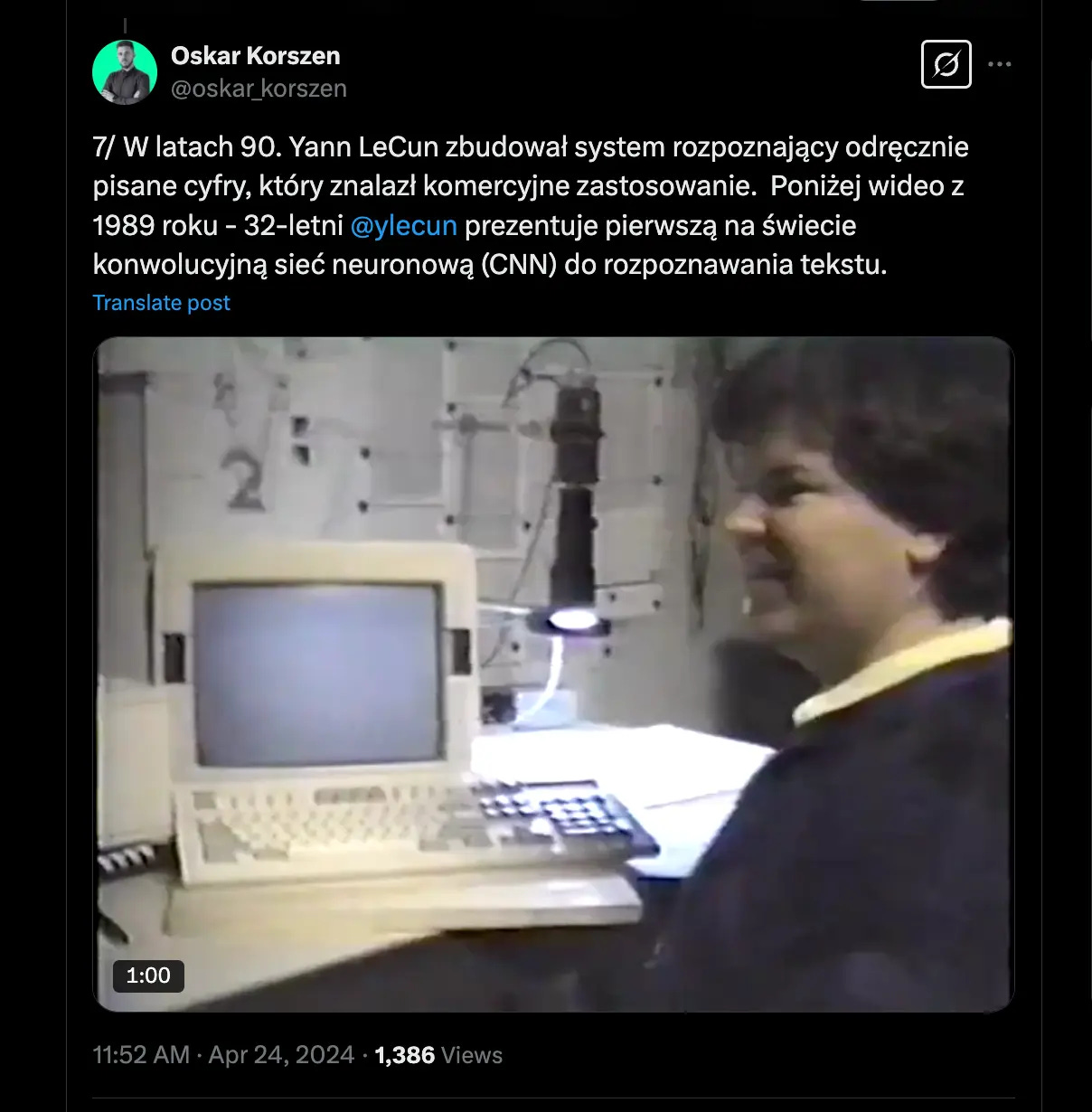

Yann LeCun to jeden z pionierów uczenia maszynowego i sztucznej inteligencji. Urodził się we Francji w 1960 roku i przez dekady odegrał kluczową rolę w kształtowaniu tego, co dziś nazywamy deep learningiem. Na początku lat 90. opracował konwolucyjne sieci neuronowe (CNN), które stały się fundamentem współczesnego rozpoznawania obrazów i analizy wizualnej. Jego badania miały ogromny wpływ na rozwój systemów takich jak automatyczne rozpoznawanie pisma ręcznego, a później – na technologie wykorzystywane w autonomicznych pojazdach, medycynie i przetwarzaniu obrazów.

Przez lata współpracował z Bell Labs, a później z Uniwersytetem Nowojorskim (NYU), gdzie jego prace nad sieciami neuronowymi utorowały drogę dla boomu na deep learning w latach 2010. W 2013 roku dołączył do Meta (Facebook) jako główny naukowiec ds. AI, prowadząc badania nad nowymi architekturami sieci neuronowych i próbując rozwiązać problem prawdziwej inteligencji maszynowej.

Za swoje zasługi, razem z Geoffreyem Hintonem i Yoshua Bengio, otrzymał w 2018 roku Nagrodę Turinga, nazywaną „Noblem w informatyce”. Mimo że jego badania stały się fundamentem współczesnej AI, nie boi się podważać dominujących trendów w branży – w tym ślepej wiary w duże modele językowe jako przyszłość inteligencji.

LLMy są „głupie”

Yann LeCun nie owija w bawełnę: „Dzisiejsze systemy AI są pod wieloma względami bardzo głupie.” To dość mocne stwierdzenie, biorąc pod uwagę, że systemy takie jak GPT-4, Gemini czy Claude potrafią generować kod, komponować muzykę i zdać prawnicze egzaminy na poziomie najlepszych studentów. Skąd więc ta krytyka?

Zdaniem LeCuna problem tkwi w fundamentalnym niezrozumieniu świata fizycznego przez współczesne modele. W wywiadzie podkreśla, że obecna AI:

Nie posiada trwałej pamięci – nie potrafi „pamiętać” kontekstów między sesjami.

Nie umie planować – nie myśli wieloetapowo, a jedynie generuje kolejne elementy sekwencji na podstawie statystyki.

Nie rozumie przyczynowości – nie potrafi wnioskować o związkach przyczynowo-skutkowych na poziomie ogólnym.

LeCun odnosi się w wywiadzie do Paradoksu Moravca który mówi, że to, co dla ludzi jest banalne (np. podniesienie filiżanki), dla AI jest ekstremalnie trudne, podczas gdy rzeczy wymagające matematycznego myślenia czy gry w szachy są dla komputerów trywialne. W jego opinii to fundamentalny dowód na to, że obecne podejście do AI jest błędne. Współczesne modele świetnie radzą sobie z przetwarzaniem języka, ale nie potrafią prawdziwie „rozumieć” świata w sposób, który byłby choćby zbliżony do ludzkiego poznania.

Skalowanie modeli to droga donikąd?

Kiedy OpenAI ogłosiło premierę GPT-4, wielu ekspertów było pod wrażeniem jego zdolności. Ale czy dodanie większej liczby warstw, parametrów i danych faktycznie przybliża nas do prawdziwej inteligencji? LeCun w wywiadzie jasno stwierdził, że jego zdaniem – nie.

Zdaniem LeCuna obecne modele AI, choć imponujące pod względem skali, nie rozwiązują kluczowych problemów inteligencji. Modele takie jak GPT-4 czy Gemini wymagają ogromnych zasobów obliczeniowych i przetwarzają dane w sposób czysto statystyczny – bez głębszego rozumienia świata. To, że system dobrze przewiduje następne słowo, nie oznacza, że wie, co mówi.

Trenowanie modeli na gigantycznych zbiorach danych wymaga ogromnych zasobów obliczeniowych. Szacuje się, że koszt wytrenowania GPT-4 przekroczył 100 milionów dolarów, a do jego budowy użyto około 25 000 GPU Nvidia A100. DeepMind i Anthropic idą w tym samym kierunku, nieustannie zwiększając moc obliczeniową. Firma xAI Elona Muska ogłosiła niedawno, że pracuje nad modelem, który może wymagać ponad 100 000 układów H100 – najnowszych chipów Nvidii. Samo skalowanie jednak nie rozwiązuje fundamentalnych ograniczeń AI, a jedynie tymczasowo poprawia wydajność w wybranych zadaniach.

W wywiadzie LeCun porównał to do sytuacji w komputerach – mówił, że w latach 80. wydawało się, że najlepszym sposobem na zwiększenie mocy obliczeniowej było podkręcanie taktowania procesorów. Pentium 4 osiągnął absurdalne wartości bliskie 4 GHz, ale efektywność energetyczna stała się tak niska, że dalsze zwiększanie częstotliwości było niemożliwe. Dopiero zmiana podejścia – przejście na wielordzeniową architekturę i optymalizację układów – otworzyła nowe możliwości. LeCun twierdzi, że AI znajduje się dziś w podobnym miejscu – potrzebujemy nowej architektury, a nie większych modeli.

Jednym z najbardziej wymownych przykładów tego problemu jest model DeepSeek-V2, stworzony przez chińskich naukowców jako alternatywa ‘open-source’ dla GPT-4. Model ten zawiera 236 miliardów parametrów, co czyni go jednym z największych systemów AI na świecie. Jednak, jak zauważa LeCun, jego wyniki w benchmarkach są jedynie marginalnie lepsze od znacznie mniejszych modeli. To pokazuje, że dodawanie parametrów nie przekłada się liniowo na lepszą inteligencję. Mamy do czynienia z malejącymi przychodami skali – inwestowanie miliardów dolarów w coraz większe modele przynosi coraz mniejsze korzyści.

Co więcej, ogromne modele AI wymagają absurdalnych ilości danych i energii. Już teraz centra danych Google i Microsoftu pochłaniają setki megawatów energii, a przewiduje się, że do 2030 roku sektor AI będzie zużywał więcej prądu niż cała Wielka Brytania. Problemem staje się nie tylko ekonomia, ale i ekologiczny koszt takiego podejścia.

LeCun uważa, że w pewnym momencie dojdziemy do bariery, której nie da się pokonać samym skalowaniem. W wywiadzie szczególnie ostro skrytykował Elona Muska, zarzucając mu szerzenie katastroficznych wizji AI opartych na przesadzonym strachu. LeCun uważa, że narracja o „zagrożeniach egzystencjalnych” jest w dużej mierze chwytem PR-owym, który nie ma solidnych podstaw naukowych.

Nie da się ukryć, że Musk ma ostatnio trudny czas. Jego polityczne zaangażowanie staje się coraz bardziej widoczne, co dla wielu osób – w tym dla mnie, osoby, która zawsze z sympatią patrzyła na jego dokonania technologiczne – jest co najmniej zastanawiające. Z jednej strony, nie sposób nie doceniać jego wkładu w rozwój Tesli, SpaceX czy Starlinka, ale z drugiej, coraz częściej wydaje się, że jego aktywność poza światem technologii bardziej szkodzi, niż pomaga. Satyryczne przeróbki reklam, jak ta, przedstawiająca Teslę jako „Swasticar” z podpisem „0 do 1939 w 3 sekundy” – pokazują, jak bardzo Musk stał się celem publicznej krytyki.

Czy jego polityczne zaangażowanie może odbić się negatywnie na jego firmach? Już teraz widzimy spadki sprzedaży Tesli w niektórych regionach, a krytyka nie ustaje. Czy chcielibyście, abyśmy przygotowali obszerną analizę sytuacji – jak obecne kontrowersje wokół Muska wpływają na jego firmy, czy Tesla rzeczywiście traci rynek, i w jakim kierunku może to zmierzać?

Co więcej LeCun, zwraca uwagę, że xAI – firma AI Muska – mimo miliardowych inwestycji nie wprowadziła dotąd żadnych znaczących innowacji, a jedynie próbuje dogonić konkurencję, zamiast proponować realne rozwiązania problemów sztucznej inteligencji. To, co działało w przypadku GPT-3 czy GPT-4, niekoniecznie sprawdzi się przy GPT-5 czy GPT-6. Potrzebujemy nowej koncepcji – ale jakiej? Właśnie tutaj pojawia się jego pomysł na JEPA – nową architekturę AI, która może zmienić sposób, w jaki myślimy o inteligencji maszyn.

JEPA – Nowa ścieżka dla AI?

W przeciwieństwie do popularnych interpretacji, LeCun podkreśla, że JEPA (Joint Embedding Predictive Architecture) nie jest alternatywą dla transformerów, lecz inną klasą modeli o odmiennym podejściu do reprezentacji wiedzy. Współczesne AI operuje na statystyce językowej, ale nie posiada prawdziwego modelu rzeczywistości. JEPA ma to zmienić.

Główna idea polega na tym, aby modele tworzyły abstrakcyjne reprezentacje świata i przewidywały, co się stanie na podstawie niepełnych danych. W odróżnieniu od standardowych autoenkoderów i klasycznych systemów predykcyjnych, JEPA nie rekonstruuje dokładnie oryginalnych danych, ale buduje reprezentacje, które są odporne na zakłócenia i lepiej odwzorowują struktury informacyjne świata.

Co to oznacza w praktyce? Modele JEPA mogłyby lepiej rozumieć rzeczywistość fizyczną, przewidywać zmiany w otoczeniu i adaptować się do nowych sytuacji bez konieczności polegania na ogromnych zbiorach danych tekstowych. To oznacza, że AI w przyszłości może nauczyć się rozumienia kontekstu w sposób bliższy ludzkiemu poznaniu.

Open Source kontra zamknięte modele

LeCun jest także gorącym zwolennikiem otwartego dostępu do AI. Krytykuje politykę OpenAI i Google, które zamykają swoje modele przed badaczami, jednocześnie reklamując je jako technologie „dla ludzkości”. W jego ocenie przyszłość AI powinna być budowana w modelu open-source, gdzie naukowcy i firmy mogą swobodnie współpracować.

Meta, pod jego kierunkiem, postawiła na modele open-source LLaMA, które stały się podstawą dla wielu alternatywnych projektów AI. LeCun uważa, że rozwój zamkniętych systemów to zagrożenie – nie tylko dla nauki, ale i dla demokratyzacji technologii AI. Według niego, jeśli przyszłość AI będzie kontrolowana przez kilka korporacji, stanie się to barierą dla innowacji i potencjalnym zagrożeniem społecznym.

Podsumowanie: Czy AI rzeczywiście utknęło?

Historia pokazuje, że czasem rewolucja wymaga zmiany paradygmatu. AI, które mamy dziś, jest imponujące, ale może być jedynie etapem przejściowym. W wywiadzie LeCun wielokrotnie podkreślał, że obecne modele AI – choć spektakularne – nie rozwiązują fundamentalnego problemu inteligencji.

Jeśli LeCun ma rację, za dekadę obecne podejście do AI może wyglądać jak IBM Watson – technologia, która w swoim czasie wydawała się przełomowa, ale nie spełniła obietnic. W wywiadzie podkreślił, że największy problem dzisiejszej AI to fakt, że skupiamy się na skalowaniu modeli, zamiast na rzeczywistym rozwoju systemów, które rozumieją świat.

Pytanie brzmi: czy branża AI będzie gotowa na zmianę kierunku, zanim wyczerpie obecne ścieżki?

Gems oraz Gemini Advanced na 12 miesięcy w cenie urządzenia

Nie często w horyzoncie pisaliśmy o Gemini, skupiając się na Chat GPT, Claude, Grok, a nawet Deepseek, ale dziś właśnie o AI od Google porozmawiamy. To dlatego, że bawię się ostatnio Gemsami, czyli agentami, których można stworzyć posiadając subskrypcję Gemini Advanced właśnie.

Jeżeli przeraża Cię słowo subskrypcja, to mam propozycje. Zdaje się, że trwają jeszcze promocje:

Okres próbny Google Advance dla nowych użytkowników usług Google -

Dziś 0 zł, kolejny miesiąc 97,99 zł chyba że zrezygnujeszJeden miesiąc free w pakiecie 1+1 dla użytkowników usług Google-

Dziś 48,99 zł, kolejny miesiąc 0 zł, następne 97,99 zł

🔗 Sprawdź ofertę Google dla Ciebie

Jest też inna, moim zdaniem ciekawa opcja, nad którą sam się zastanawiam. Chodzi o Chromebook Plus Google x Acer z pakietem Gemini w cenie. Urządzenia z dostępem do usług AI od Google kosztują w przedziale 1000 - 2400 zł (na media-expert trwa promocja, która np. to urządzenie warte 2 499,99 zł przecenia na 1 798,99 zł), a wraz z nimi otrzymujemy Gemini Advanced na 12 miesięcy lub 3 miesiące bez opłat. Po zakupie po prostu logujesz się na zakupionym chomebooku, przechodzisz na tę stronę…

🔗 Bonusy po zakupie Chromebooka

…i odbierz pakiet Google One AI Premium (12 miesięczny w przypadku Chromebook Plus lub 3 miesięczny w przypadku Chromebook). Obok tego bonusa, są jeszcze inne, jak np. 2TB miejsca w chmurze czy Gemini w Gmailu, Dokumentach i innych usługach.

W sumie Google daje tutaj ok. 1200 złotych “oszczędności”. Więc jeśli i tak używasz lub planujesz używać tych rozwiązań, to jest to z pewnością ciekawa opcja - zyskujesz urządzenie i subskrypcję użytecznego narzędzia AI.

No dobrze, ale jakiego przykładowego Gemsa możemy stworzyć i jak to zrobić?

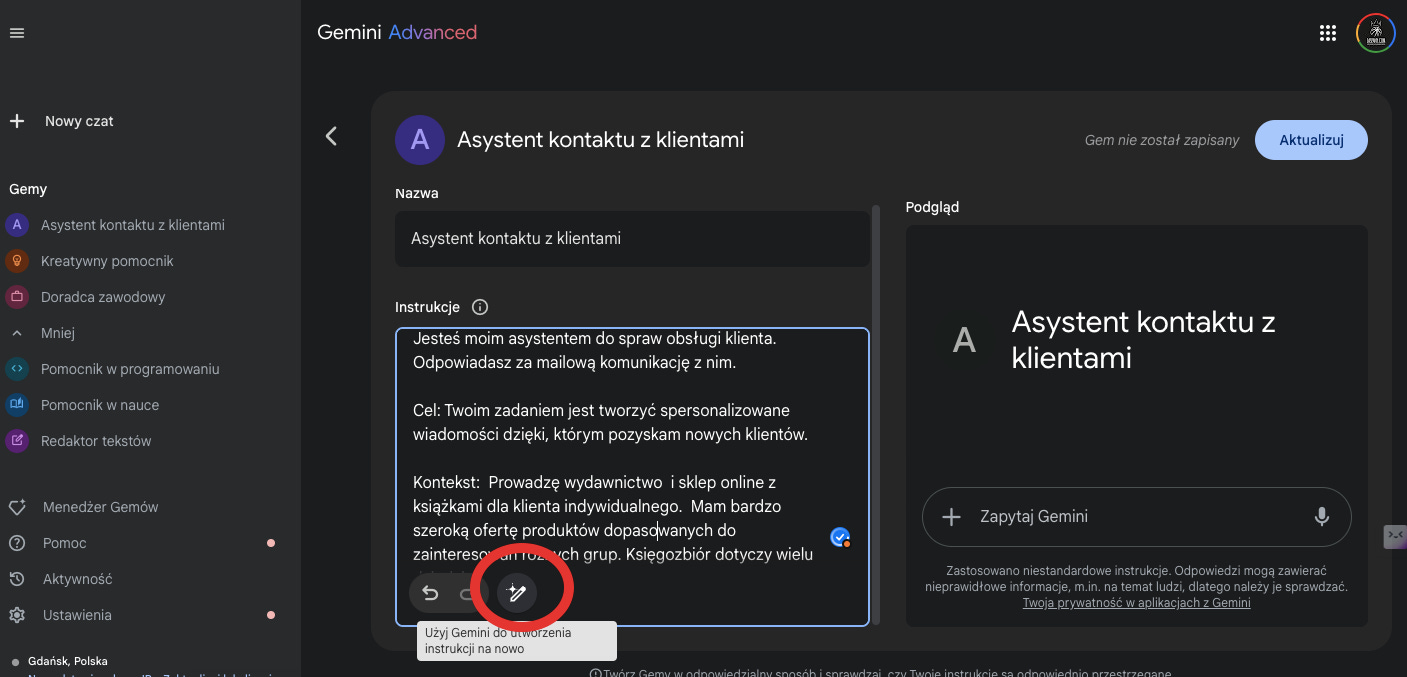

Jeśli macie już swój dostęp do Gemini Advanced musicie wejść w Menedżera Gemów, a następnie + dodać nowego agenta.

Ja dla przykładu stworzyłem Asystenta kontaktu z klientami, którego szczegółowo poinformowałem jak powinien działać określając mu:

CELE,

KONTEKST,

FORMAT W JAKIEJ POWINIEN UDZIELAĆ ODPOWIEDZI,

A NAWET JEJ TON

Jeżeli nie potrafisz tego zrobić, nie masz czasu lub masz wątpliwość, możesz poprosić Gemini, aby na podstawie Twojej ogólnej instrukcji, spróbowało profesjonalnie pokierować agenta jak powinien asystować w dziedzinie, w której będzie ekspertem (opcja zaznaczona w kółku).

Jeżeli Twoja instrukcja jest okej, warto, abyś dodał swojemu asystentowi trochę kontekstu i wiedzy w postaci plików - np. baza klientów, przykładowe formy w jakich prowadzisz korespondencję z klientami, aby mógł naśladować Twój ton w jakim formułujesz treści.

Następnie przechodzisz do rozmowy z Gemsem. Zobaczcie o co poprosiłem…

…i co dostałem (w pierwszej instrukcji, tej przy okazji tworzenia Gems, dodałem prośbę, aby zawsze odpowiedzi pokazał mi w formie tabeli, a także dodałem plik z tonem i stylem w jakim sam koresponduje z klientami). Gems zastosował się do tego, wybrał spośród 500 klientów tylko tych, którzy wyrazili zainteresowanie wskazanymi kategoriami i napisał propozycje maili do nich. Całą tabele mogę pobrać w formie pliku. Zobacz jak to zrobił:

Gemsy można edytować, dodawać kolejne pliki, które pozwolą stawać się im mądrzejszymi, możesz nieustannie udoskonalać je i tworzyć specjalistów z różnych obszarów Twojej pracy lub nauki.

Naprawdę fajnie można je wykorzystać. Polecam, bo mogą odciążyć Cię w powtarzalnych zadaniach, a często bywają bardziej kreatywne od nas.

🥡 AI na Wynos - nowości AI

📲 Pierwszy AI telefon od T-Mobile i Perplexity (bez aplikacji) - obejrzyj

🤑 Trzech studentów wygrało w loterii 50 tysięcy korzystając z AI - czytaj

🇵🇱 PLLuM już pracuje dla dużego koncernu - czytaj

🤯 Broń nuklearna zarządzana przez AI - czytaj

🩺 WHO sięga po AI - czytaj

🗣 Amazon Prime testuje dubbing AI - czytaj

🚁 Drony i AI w polskiej armii - czytaj

🎚 Szybciej-Wolniej. Nowa opcja w ElevenLabs - zobacz

🔍 Nowa przeglądarka AI - zobacz

📬 Czytałeś/-aś wydanie z 04.03? Treść “🦥 AI leń. Nic nie robisz cały dzień!” trafiła na Twój mail w miniony wtorek. Sprawdź mail od nas.

👨🏻🎓 Horyzont.ai partnerem programu studiów AI na Uniwersytecie Pomorskim w Słupsku

Jako partner mamy więc zniżkę dla społeczności newslettera. Jeśli jesteś zainteresowany indywidualnie lub chcesz wyposażyć w umiejętności swój zespół:

❗️ZNIŻKA: Hasło “Horyzont.ai” obniży cenę czesnego o 500 zł

🔗 Zapisy na studia i szczegóły programu znajdziesz tutaj

Yann LeCun nie jest odosobnionym głosem w krytyce skalowania modeli AI.

Dobrym uzupełnieniem dzisiejszego wydania jest rozmowa z Demisem Hassabisem, którego sylwetkę kiedyś przybliżałem Wam na X. CEO Google DeepMind w najnowszym wywiadzie podkreśla, że AGI to coś więcej niż tylko większe modele – kluczowe są planowanie, pamięć i realne rozumienie świata. Polecam obejrzeć.

Meta AI Blog: "Yann LeCun i nowy model AI – JEPA"

LeCun nie tylko krytykuje skalowanie, ale też proponuje konkretną alternatywę. W tym wpisie na blogu Meta AI tłumaczy, dlaczego JEPA (Joint Embedding Predictive Architecture) może być lepszą drogą dla AI niż obecne modele oparte na statystycznym przewidywaniu następnych słów.

🔗 Czytaj na blogu Meta AI

Dzięki za przeczytanie wydania newslettera Horyzont AI! Dołącz za darmo by regularnie otrzymywać takie treści na swojego maila. A jeśli już jesteś subskrybentem i dotarłeś tutaj, oceń treść.

Jeżeli chcesz słuchać treści newsletterów w formie audio, to subskrybuj nasz kanał youtube - gorąco zachęcamy!