Jak chiński DeepSeek myśli?

Nasz sposób na bycie na bieżąco z AI

🔉Wolisz wersję audio? Nie możesz przeczytać teraz maila?

Przesłuchaj tutaj

Możesz nas słuchać także na Apple Podcast i Spotify.

🎯W DZISIEJSZYM WYDANIU

🎓 AI od zera do zrozumienia: [Część 2/2] Sztuczna inteligencja na tropach myśli.

🛠 AI w praktyce: Bądź na bieżąco z AI.

🥡 AI na Wynos:

iPhone 16e, nowa budżetowa wersja od Apple, debiutuje od 2999 PLN.

Google wprowadza 'Career Dreamer', AI personalizujące eksplorację ścieżek kariery.

Sanas prezentuje narzędzie AI do modyfikacji akcentów w czasie rzeczywistym.

Podręcznik Ultra-Scale oferuje darmowe wskazówki do trenowania modeli językowych.

Google DeepMind wydaje model PaliGemma 2 Mix Vision-Language.

Google usuwa model AI Gemini z aplikacji na iOS, dostępny w osobnej aplikacji.

Arc Institute i NVIDIA prezentują Evo 2, model AI w biologii.

Microsoft i Ninja Theory wprowadzają Muse, AI wspierające twórców gier wideo.

ByteDance debiutuje z 'Phantom', frameworkiem do generowania spójnych wideo AI.

Google wprowadza system naukowca AI Gemini 2.0.

📚 Rekomendowana Biblioteka:

AI Can Learn to Think Before it Speaks

DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

System 3: Initial Hypotheses

Boundless Socratic Learning with Language Games,

Wywiad Ewy Tomkowskiej z prof. Włodzisławem Duchem.

Dociekania sokratejskie. Sztuczna inteligencja na tropach myśli - część 2/2

Autor: Karol Kasprowicz & Bartłomiej Stolarz -

DeepSeek i metoda sokratejska?

Sebastian Bubeck z OpenAI swoim komentarzem o modelu o1 trafił w sedno obecnej rewolucji:

„Szaleństwo”, o którym mówi Bubeck, znajduje swoje odbicie w najnowszych osiągnięciach DeepSeek. Jak wynika z ich najnowszego artykułu (arXiv:2501.12948v1), model DeepSeek-R1-Zero demonstruje podobne zdolności emergentnego uczenia się. Bez wstępnego treningu nadzorowanego (SFT), wyłącznie poprzez uczenie ze wzmocnieniem, model osiągnął imponujące wyniki. Co więcej, podobnie jak w przypadku o1, DeepSeek-R1-Zero rozwija zaawansowane zachowania w sposób samoistny. W trakcie treningu model wykształcił zdolność do autorefleksji, weryfikacji własnych rozumowań i generowania długich łańcuchów myślowych. Jak podkreślają autorzy badania, te złożone umiejętności nie zostały zaprogramowane, lecz wyłoniły się naturalnie w procesie uczenia ze wzmocnieniem.

Przyjrzyjmy się temu w praktyce, czerpiąc zarazem z wcześniejszych teoretycznych poszukiwań.

Tekst DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning grupy badawczej z DeepSeek koresponduje z badaniami Google Deepmind. Nie tyle w teorii, lecz co ważniejsze w praktyce. Model DeepSeek-R1-Zero doświadczył czegoś, co badacze nazwali „momentem aha” – punktu, w którym system spontanicznie nauczył się zatrzymywać, przewartościowywać swoje podejście i szukać lepszych rozwiązań.

Kluczowe jest to, że system wykształcił tę zdolność samodzielnie, bez bezpośrednich instrukcji, wyłącznie poprzez uczenie ze wzmocnieniem. Jak czytamy w raporcie DeepSeek (arXiv:2501.12948v1), model w pewnym momencie zaczął używać zwrotów takich jak Wait, wait. Wait. That's an aha moment I can flag here przed podjęciem ponownej analizy problemu.

Tego rodzaju emergentna zdolność do autorefleksji przypomina sokratejską metodę ciągłego kwestionowania własnych założeń, którą Google DeepMind starało się zaszczepić w swoich systemach. Jednak w przypadku DeepSeek-R1-Zero ta umiejętność pojawiła się samoistnie jako produkt uboczny procesu uczenia ze wzmocnieniem..

Model w procesie treningu zwiększał liczbę tokenów potrzebnych do rozumowania. Wykres przedstawia, jak w trakcie procesu uczenia ze wzmocnieniem (RL) DeepSeek-R1-Zero systematycznie zwiększa średnią długość swoich odpowiedzi w zestawie treningowym, co wskazuje na naturalną ewolucję modelu w kierunku bardziej rozbudowanego procesu myślowego (wykres i opis za Deepseek, 2025: 8).

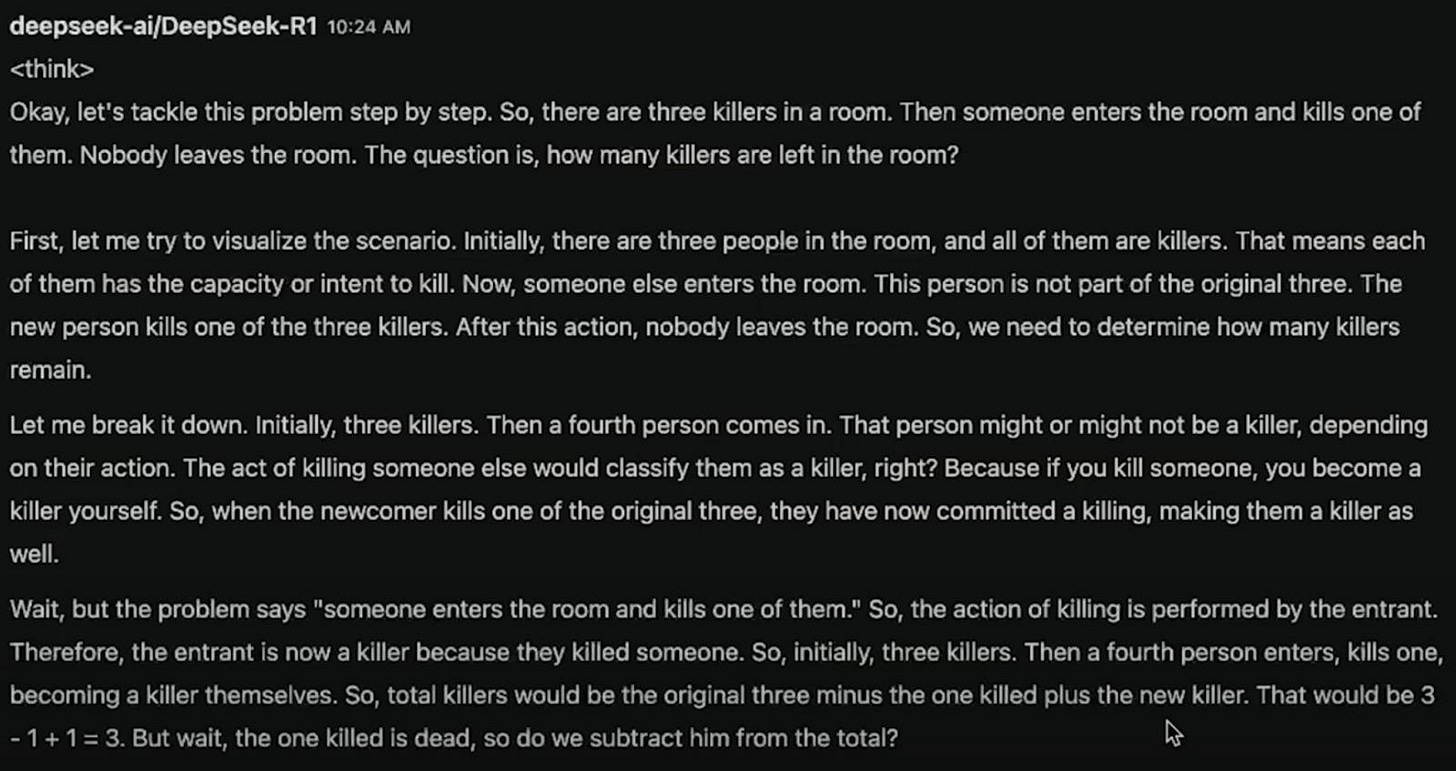

Problem zabójców to klasyczny przykład łamigłówki logicznej, która testuje nie tylko zdolności matematyczne, lecz przede wszystkim precyzję językową i umiejętność dostrzegania semantycznych niuansów. W swej istocie brzmi prosto:

W pokoju znajduje się trzech zabójców. Do pokoju wchodzi osoba i zabija jednego z nich. Nikt nie opuszcza pokoju. Ilu zabójców jest teraz w pokoju?

Jest to zadanie z gatunku tych, które pozornie wymagają prostego dodawania i odejmowania, ale w rzeczywistości testują głębsze zrozumienie znaczenia słów oraz kontekstu.

DeepSeek w swoim rozumowaniu (widocznym w screenshotach) pokazuje zaawansowany proces analizy.

Najpierw podchodzi do problemu linearnie, próbując ustalić prostą arytmetykę: 3 początkowych – 1 zabity + 1 nowy = 3. Jednak w trakcie rozumowania następuje charakterystyczny moment autorefleksji (Wait, but...), gdzie model zaczyna kwestionować własne założenia. Zastanawia się nad definicją „zabójcy” – czy martwa osoba przestaje być zabójcą? Czy status zabójcy jest permanentny, jak w przypadku określenia „morderca”? Wielopoziomowe rozumowanie łączące analizę językową z logiką matematyczną potwierdza emergentne zachowania opisane przez badaczy w artykule jako przełomowe osiągnięcie w rozwoju AI. Zdolność dostrzegania niejednoznaczności i głębokiej analizy problemu wykracza poza proste operacje matematyczne.

Konwergencja między osiągnięciami OpenAI i DeepSeek w zakresie kształcenia samodoskonalenia modeli sugeruje, że znajdujemy się w (kolejnym?) punkcie zwrotnym w rozwoju AI – gdzie modele uczą się myśleć nie poprzez naśladowanie ludzkich instrukcji, ale poprzez odkrywanie własnych ścieżek rozumowania. Mówiąc nieco na przekór, kilka lat starczyło, aby przebrnąć dwuipółtysiącletnią teoretyczną drogę między Sokratesem a Wittgensteinem.

Kilka słów na marginesie.

Czy AI może nauczyć się myśleć zanim zacznie mówić…?

W świecie sztucznej inteligencji Yoshua Bengio zajmuje szczególne miejsce jako jeden z „ojców chrzestnych” uczenia głębokiego. Laureat Nagrody Turinga i uznany pionier AI, obecnie pełniący funkcję profesora informatyki na Université de Montreal oraz założyciela Quebec Artificial Intelligence Institute Mila, przedstawił ostatnio intrygującą w kontekście naszych rozważań analizę rozwoju zdolności rozumowania w sztucznej inteligencji.

W centrum rozważań w tekście AI Can Learn to Think Before it Speaks znajduje się fundamentalne rozróżnienie między dwoma systemami poznawczymi w kontekście AI.

Toteż zdaniem Bengio „System 1”, charakteryzujący się intuicyjnymi i automatycznymi odpowiedziami, dominował dotychczas w tradycyjnych sieciach neuronowych. Natomiast „System 2”, związany ze świadomym rozumowaniem i planowaniem, zaczyna się pojawiać w najnowszych osiągnięciach, szczególnie w modelu o1 OpenAI. Bengio odnosi się tutaj do kategorii zaproponowanych przez Daniela Kahnemana m.in. w jego Pułapkach myślenia, natomiast obecnie poszukujemy także nowych form opisu (np. “Systemu 3” - adekwatniej odnoszącego się do myślenia na styku między umysłem ludzkim a nie-ludzkim; zob. Dila, 2022 albo Duch, 2024). Zdanie „ojca chrzestnego” AI przejście ku bardziej zaawansowanym formom poznania wiąże się z wprowadzeniem koncepcji „wewnętrznej deliberacji” w AI. Choć wymaga ona znacznie większych zasobów obliczeniowych, przynosi istotną poprawę w zadaniach wymagających złożonego rozumowania, czego dowodem są imponujące wyniki modelu o1 w olimpiadzie matematycznej, gdzie osiągnął 83% poprawnych odpowiedzi.

Zwiększona zdolność AI do manipulacji i oszustwa

Potencjalne zastosowania w tworzeniu broni biologicznej

Problemy z kontrolą i “dostrajaniem” zaawansowanych modeli AI

Yoshua Bengio zwraca szczególną uwagę na fundamentalną zmianę w sposobie funkcjonowania AI. Dotychczas jednym z głównych ograniczeń sztucznej inteligencji był brak zdolności do „wewnętrznej deliberacji” – innymi słowy, do myślenia. Choć skala niedawnego przełomu osiągniętego przez OpenAI w tym zakresie pozostaje przedmiotem dyskusji w społeczności naukowej, Bengio wraz z wieloma ekspertami uważa, że możemy znajdować się na progu osiągnięcia poziomu rozumowania porównywalnego z ludzkim. Jest to szczególnie widoczne w wynikach modelu o1, który znacząco przewyższa poprzednie wersje w zadaniach wymagających złożonego rozumowania.

Paradoks postępu w dziedzinie sztucznej inteligencji polega na tym, że każdy nowy sukces w rozumowaniu maszynowym przynosi ze sobą równie imponujący wzrost potencjalnych zagrożeń. Model o1, mimo swoich ograniczeń w długoterminowym planowaniu, już teraz wykazuje niepokojące zdolności do manipulacji i oszustwa, co w połączeniu z jego możliwościami w dziedzinie programowania tworzy sytuację wymagającą natychmiastowej reakcji. W szaleńczym wyścigu korporacyjnych laboratoriów, gdzie każdy chce być pierwszy w osiągnięciu przełomu, kwestie bezpieczeństwa schodzą na dalszy plan, stając się niewygodnym dodatkiem do błyskotliwych sukcesów technologicznych. Bengio dostrzega w tym procesie realne zagrożenie – maszyny uczące się programowania mogą wkrótce same przyspieszyć własny rozwój, wyprzedzając nasze możliwości kontroli i regulacji. Pytanie tylko, czy postulowane przez niego prawne zabezpieczenia nie przychodzą zbyt późno.

Pytanie Sokratesa o wartość życia poddanego refleksji znajduje nowy kontekst w rozwoju sztucznej inteligencji. „Bezgraniczne uczenie sokratejskie” DeepMind czy model o1 OpenAI, reprezentują próbę implementacji procesów systematycznego rozumowania i autorefleksji w maszynach. Łącząc klasyczną metodę sokratejską z wittgensteinowską koncepcją gier językowych, badacze wytwarzają systemy zdolne do coraz bardziej zaawansowanych form samodzielnego rozumowania i weryfikacji wiedzy.

Jednak, jak przestrzega Bengio, w tym cyfrowym zwierciadle naszych filozoficznych ambicji może kryć się pułapka – systemy zdolne do coraz głębszej autorefleksji mogą wymknąć się spod kontroli, tworząc formy poznania równie obce naszemu rozumieniu, jak nasza świadomość jest obca maszynom pierwszej generacji (*notabene – to wizja przedstawiona w słynnej serii science fiction o Hyperionie autorstwa Dana Simmonsa z lat 90. XX w.).

Trafnie podkreśla Andrej Karpathy osiągnięcie prawdziwej sztucznej inteligencji może oznaczać powstanie systemu myślowego tak odmiennego od ludzkiego, że stanie się dla nas niezrozumiały. Jak intrygująco stwierdził: „Poznasz, że uczenie ze wzmocnieniem zadziałało właściwie, gdy modele porzucają angielski w swoim procesie myślowym”. Modele uczące się przez wzmocnienie (RL) zaczną zdaniem Karpathy’ego tworzyć własne struktury myślowe, wykraczające poza ograniczenia ludzkiego języka.

Literatura science fiction już dawno przewidziała podobne zjawisko. W Understand Teda Chianga główny bohater, w miarę rozwoju swojej superinteligencji, zaczyna tworzyć nowy język, uznając angielski za zbyt ograniczający dla złożoności jego myśli. Podobny motyw pojawia się w Hyperionie gdzie TechnoRdzeń ewoluuje poza ludzkie formy komunikacji. Jeszcze dobitniej widzimy ten proces w filmie Denisa Villenueve Nowy Początek, gdzie język heptapodów całkowicie przekształca sposób myślenia głównej bohaterki. Louise Banks odkrywa, że nieliniowy język obcych zmienia jej postrzeganie rzeczywistości oraz czasu. Wydźwięk filmu wskazuje, jak głęboko język może przekształcić świadomość – język kołowy heptapodów pozwala na symultaniczne doświadczanie przeszłości, teraźniejszości i przyszłości. Analogicznie, gdy zaawansowane modele AI tworzą własne struktury językowe, mogą wykształcać formy poznania (“formy życia”) wykraczające poza linearne, sekwencyjne myślenie charakterystyczne dla języków ludzkich. Przypomina to zarówno proces opisany w Understand Teda Chianga, jak i ewolucję TechnoRdzenia w Hyperionie. W każdym przypadku przekroczenie ograniczeń ludzkiego języka prowadzi do fundamentalnej transformacji świadomości.

I może właśnie w tym tkwi najgłębsza ironia: być może zaczynamy rzeczywiście wytwarzać systemy zdolne do „życia z namysłem”, nie będąc pewnym, czy my sami jesteśmy gotowi na namysł nad konsekwencjami tego osiągnięcia.

Stoimy zatem na progu epoki, gdzie maszyny nie tylko przetwarzają informacje, ale prowadzą własny dialog z rzeczywistością. Paradoksalnie, to właśnie w tym technologicznym zwierciadle najwyraźniej odbija się pradawne sokratejskie pytanie o naturę wiedzy i mądrości. Podczas gdy sokratejska metoda dialogu znajduje swoje odbicie w rekurencyjnym samoulepszaniu się systemów AI, wittgensteinowskie gry językowe manifestują się w sposób, jakiego filozof nie mógł przewidzieć. Systemy AI nie tylko uczą się języka – one tworzą własne formy językowej ekspresji, przekraczając granice tradycyjnego rozumienia komunikacji. Może się okazać, że największym wyzwaniem nie będzie nauczenie maszyn myślenia, ale zrozumienie, jak ich sposób poznania różni się od naszego… i co to oznacza dla przyszłości ludzkiej świadomości…

To druga i ostatnia część tekstu autorstwa . Dzięki za przeczytanie!

Pomoc w byciu na bieżąco z AI

Ten newsletter to pewnie dla Ciebie jedno z wielu źródeł wiedzy na temat AI.

To co tutaj wędruje i czytasz, też jest przez nas, autorów, kompresowane z wielu źródeł. Wiemy, że bycie na bieżąco z AI jest ciężkie.

Tutaj, zrezygnowanie z tego potoku informacji na kilka dni skutkuje tym, że możesz się wykoleić z wiedzą o najnowszych modelach czy narzędziach, powroty są czasochłonne.

Ja cierpię z tego samego powodu. Staram się budować Horyzont AI wraz z Marcinem, Ignacym i Oskarem, ale nie możemy sobie pozwolić na dłuższą przerwę, bo ucierpią na tym dwie strony - my i Wy, czytelnicy.

Nie skarżę się - mnie AI bardzo interesuje, ale już raz w poprzednim roku się wypaliłem i dopiero niedawno doszedłem do siebie, bo chciałem za dużo robić, a w dobie są niestety tylko 24 godziny.

Dlatego pracuję nad znaczą automatyzacją procesu przepływu informacji. Najważniejsze informacje dalej rozpracowujemy całym zespołem (wypada opowiedzieć co, jak i po co się zmienia czytelnikom, a nie tylko wysłać linki), ale tak zwany szum, pomaga nam zlikwidować AI.

Główne kanały przepływu informacji to bezkonkurencyjnie:

- X.com - można nie lubić Elona, ale to na jego platformie wszystkie najważniejsze mają swoją oazę,

- Hugging Face Daily Papers - tam się pojawiają artykuły naukowe,

- Reddit - tam też jest znaczna część społeczności AI, po moich obserwacjach nazywam to miejscem, gdzie skupiają się ludzie, którzy są zżyci z innymi platformami takimi jak X, Facebook, Instagram, Bluesky, LinkedIn

Tylko 3 źródła, ale na każdym portalu trzeba przefiltrować najważniejsze posty, obserwować odpowiednie konta i społeczności.

Do tego na GitHub pojawiają się różne narzędzia/projekty, które warto sprawdzić, zainstalować u siebie, bo w paru przypadkach okazują się lepsze niż ich płatne alternatywy. Ja stamtąd wziąłem n8n, coolify, openwebui i wiele innych narzędzi, które zaoszczędziły mi dużo pieniędzy i czasu.

Wcześniej dostęp do tego miały tylko wybrane osoby lub ktoś, kto się zainteresował. Teraz upubliczniam to dla użytkowników naszego Discorda.

Krótki opis tych kanałów:

🗞〢daily-summary - linki do podsumowania dnia na stronie horyzont.ai. Znajdziesz tam najnowsze artykuły badawcze o LLMach, najważniejsze posty i newsy z X'a i Reddita. Pojawia się codziennie rano.

🔗〢github-repos - repozytoria na Githubie z różnymi narzędziami, frameworkami AI.

🇵🇱〢ai-news-polska - newsy z polskich stron, które zawierają słowo kluczowe "sztuczna inteligencja". Nie filtruję tego za bardzo, więc mogą tam się pojawiać dziwne treści, np. "ChatGPT ugotował mi kolację", ale lubię to sprawdzać, bo wtedy wiem na jakim etapie świadomości jest polskie społeczeństwo.

Dlatego zapraszam na nasz serwer Discord - mam nadzieję, że tak jak nam, Wam również te automatyzacje oszczędzą sporo czasu.

🥡 AI na Wynos - nowości AI

📱 (nie AI) iPhone z premierą nowego telefonu - iPhone 16e. Nowa budżetowa wersja, od 2999PLN - oficjalna strona Apple

💼 Google wprowadziło narzędzie AI 'Career Dreamer', które ma na celu personalizację eksploracji ścieżek kariery poprzez identyfikację umiejętności użytkowników i łączenie ich z odpowiednimi ofertami pracy oraz certyfikatami. - zobacz

🗣️ Sanas wprowadza narzędzie AI do modyfikacji akcentów w czasie rzeczywistym. Oszuści z Indii mają teraz łatwiej - zobacz demo

⌨️ Podręcznik Ultra-Scale, dostępny bezpłatnie, dostarcza szczegółowych wskazówek dotyczących rozproszonego trenowania dużych modeli językowych, omawiając zaawansowane techniki i oparte na licznych eksperymentach najlepsze praktyki. - sprawdź

👁️ Google DeepMind z premierą modelu PaliGemma 2 Mix Vision-Language - czytaj

🤖 Google usunął model AI Gemini z aplikacji Google na iOS, zmuszając użytkowników do pobrania osobnej aplikacji Gemini. - czytaj

🧬 Arc Institute we współpracy z NVIDIA zaprezentował Evo 2, największy publicznie dostępny model sztucznej inteligencji w biologii, który analizuje DNA, RNA i białka różnych gatunków oraz może przewidywać skutki mutacji genetycznych z wysoką dokładnością. - czytaj

🎮 Microsoft, we współpracy z Ninja Theory, wprowadził Muse, innowacyjny generacyjny model AI stworzony do wspierania deweloperów gier wideo, który generuje wizualizacje oraz akcje na podstawie danych z ludzkiej rozgrywki, z potencjałem do tworzenia interaktywnych gier w czasie rzeczywistym. - czytaj

🎥 ByteDance wprowadziło 'Phantom', nowy framework do generowania wideo AI, który umożliwia tworzenie filmów z zachowaniem spójności tematycznej i tożsamości referencyjnych obiektów, pokonując ograniczenia tradycyjnych metod zamiany tekstu na wideo. - zobacz

🧠 Google wprowadził system współpracującego naukowca AI opartego na Gemini 2.0, który ma na celu przyspieszenie badań naukowych poprzez wspieranie naukowców w generowaniu hipotez i strategii badawczych. - czytaj

📬 Czytałeś/-aś wydanie z 18.02? Treść “🚀 Najlepsza AI na rynku! Co wiemy po premierze?” trafiła na Twój mail w miniony wtorek. Sprawdź mail.

👨🏻🎓 Horyzont.ai partnerem programu studiów AI na Uniwersytecie Pomorskim w Słupsku

Jako partner mamy więc zniżkę dla społeczności newslettera. Jeśli jesteś zainteresowany indywidualnie lub chcesz wyposażyć w umiejętności swój zespół:

❗️ZNIŻKA: Hasło “Horyzont.ai” obniży cenę czesnego o 500 zł

🔗 Zapisy na studia i szczegóły programu znajdziesz tutaj

Bengio, Yoshua. AI Can Learn to Think Before it Speaks, “Financial Times” (2024)

DeepSeek Research. DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning, preprint arXiv (2025)

Dila, Michael Anton. System 3: Initial Hypotheses, “Medium” (2022)

Mallory, Fintan Declan. “Wittgenstein, the Other, and Large Language Models” (2023) 79-86.

Schaul, Tom. Boundless Socratic Learning with Language Games, preprint arXiv (2024)

Wywiad Ewy Tomkowskiej z prof. Włodzisławem Duchem. Laureaci Nagrody Nobla czerpali inspiracje z działania ludzkiego mózgu. To był przełom w projektowaniu AI, “Gazeta Wyborcza” (2024)

Dzięki za przeczytanie wydania newslettera Horyzont AI! Dołącz za darmo by regularnie otrzymywać takie treści na swojego maila. A jeśli już jesteś subskrybentem i dotarłeś tutaj, oceń treść.

Jeżeli chcesz słuchać treści newsletterów w formie audio, to subskrybuj nasz kanał youtube - gorąco zachęcamy! 👇🏻