👩🦯 Tracisz wzrok... czy pomoże Ci AI?

👩🏻💻🛒 AI w e-commerce, czyli czym jest FeedGen i jak może pomóc Twoim plikom produktowym

🔉Wolisz wersję audio? Nie możesz przeczytać teraz maila?

Przesłuchaj tutaj

Możesz nas słuchać także na Apple Podcast i Spotify.

🎯W DZISIEJSZYM WYDANIU

🎓 AI od zera do zrozumienia:

🛠 AI w praktyce: 👩🏻💻🛒 AI w e-commerce, czyli czym jest FeedGen i jak może pomóc Twoim plikom produktowym

🥡 AI na Wynos:

🚗 AI w motoryzacji

👨🏻🎓Sztuczna inteligencja w szkole to pułapka. "Zamiast się uczyć, oszczędzamy czas". Przemyślenia z sali lekcyjnej.

🎨 Nowa aktualizacja Midjourney V7.

📸 Znasz profil “Sztuczna Polska” na IG? Przeczytaj wywiad z autorem.💃 Doda vs. AI.

⚖️ Jak sztuczna inteligencja wpływa na prawo?

👻 Awatar „zeznawał” w Nowym Jorku. „Sąd był naprawdę zdenerwowany”.

⛪️ „Antiqua et nova” po polsku – prezentacja watykańskiego dokumentu o AI.

🤖 Czy chcemy być informowani, ze reklamę wygenerowała AI?

🎤 Do czego młodzież wykorzystuje AI?

⚽️ VAR a sztuczna inteligencja.

🚂 AI pomoże polskiej kolei?

🏭 Sztuczna inteligencja do spalania śmieci. Pierwszy taki system w Polsce.

📚 Rekomendowana Biblioteka:

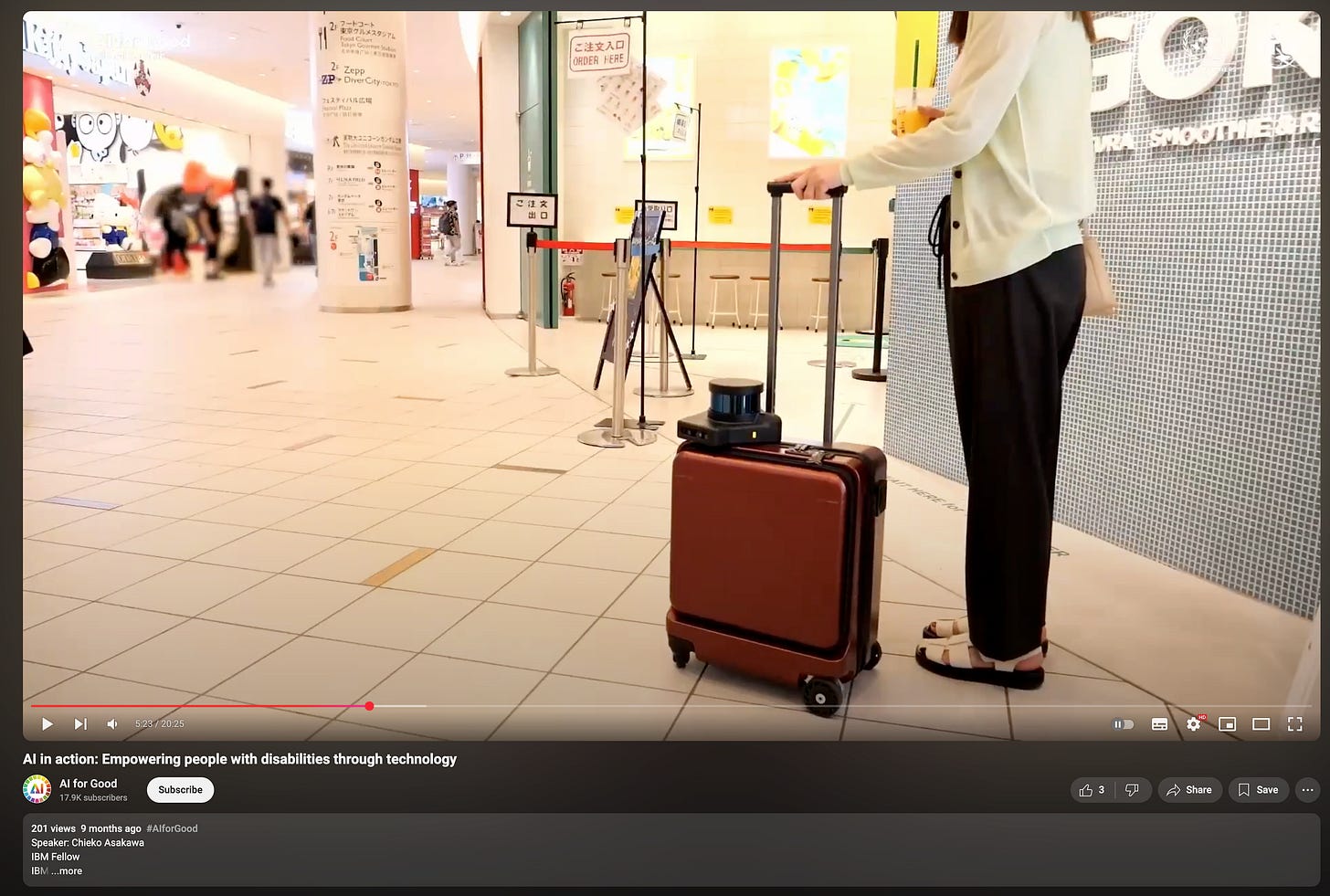

- Chieko (IBM) opowiada o tym jak straciła wzrok oraz o tym nad czym dzisiaj pracuje - wózkiem z AI, który ma pomóc niewidomym.

- Chip, dzięki któremu niepełnosprawni mogą wykonywać akcje w wirtualnej rzeczywistości - VR.

Dzisiaj AI skupia się wyłącznie na rozwiązywaniu problemów biznesowych, generowaniu zysków dla firm, inwestorów i całego ekosystemu komercji. Ale w tym pędzie zapominamy o czymś istotnym - o początkowych wizjach twórców tej dziedziny.

Alan Turing w latach 40. XX wieku, pracując nad maszynami liczącymi i testem inteligencji, oraz John McCarthy, który w 1956 roku zorganizował konferencję w Dartmouth, gdzie narodził się termin „sztuczna inteligencja", chcieli stworzyć maszynę mimikującą ludzką inteligencję. Ich wizja sięgała dalej niż tylko zastosowania komercyjne.

Dziś warto przyjrzeć się obszarowi, który czasem pozostaje w cieniu wielkich zapowiedzi i inwestycji - wykorzystaniu AI do wspierania osób z niepełnosprawnościami.

W tym artykule skupię się szczególnie na rozwiązaniach dla osób niewidomych, pokazując jak sztuczna inteligencja pomaga przełamywać bariery, z którymi mierzą się na co dzień.

👩🦯 AI dla niewidomych i słabowidzących: co mamy i dokąd zmierzamy

Sztuczna inteligencja zmienia codzienność osób, które nie widzą lub widzą słabo. Narzędzia oparte na AI czytają tekst, rozpoznają obiekty, prowadzą przez ulice i opisują świat dźwiękiem. Spójrzmy na to, co działa.

Seeing AI od Microsoftu to aplikacja, która zamienia kamerę w narratora. Czyta listy, rozpoznaje twarze, a nawet zgaduje emocje czy opisuje sceny. Działa na iOS, a od niedawna Androidzie – wszystko dzięki wizji komputerowej, częściowo w chmurze, częściowo na urządzeniu.

Lookout od Google’a robi podobne rzeczy: skanuje tekst, rozpoznaje produkty, mówi, co widzi. Działa offline, szybko, dzięki AI w telefonie. Z kolei Be My Eyes zaczęło od łączenia niewidomych z wolontariuszami przez wideo, ale w 2023 roku dodało „Be My AI” z GPT-4 Vision. Wysyłasz zdjęcie, a AI opisuje je w detalach, od razu, bez czekania na człowieka.

Są też urządzenia.

OrCam MyEye to kamera na okularach - czyta gazety, rozpoznaje twarze, ale kosztuje…dużo (£4,400). Envision Glasses od holenderskiej firmy Envision idą dalej: oparte na Google Glass, czytają tekst, rozpoznają obiekty, a dzięki GPT odpowiadają na pytania. Cena? Około £2,000.

Warto też wspomnieć o telefonach - iPhone ma VoiceOver, jak i Google Pixel, które pomagają korzystać niewidomym i słabowidzącym z telefonu.

A co z nawigacją, przemieszczaniem się, samodzielnym wychodzeniem z domu? WeWALK Smart Cane 2 to laska z ultradźwiękami i GPT, która wykrywa przeszkody, mówi, gdzie skręcić, a nawet podpowie, gdzie jest kawiarnia. Biped to kamizelka z kamerami 3D - ostrzega przed rowerami czy dziurami dźwiękiem przez głośnik. BlindSquare to Google Maps dla niewidomych.

W tym zestawieniu nie może zabraknąć ChatGPT Real-time Voice Mode z kamerą i Google Gemini Live.

To, co mamy, to już dużo. AI zamienia kamery w oczy, a sensory w przewodników. Ale są ograniczenia - ceny, dostępność, czasem zawodność. Przyszłość to więcej integracji, tańsze rozwiązania, może nawet systemy, które można sterować myślami.

Luki i ograniczenia

AI dla niewidomych to temat, który przechodzi rewolucję, ale nie bez wad. Są dziury, w których technologia się potyka, a potrzeby użytkowników zostają na lodzie.

Dokładność? Imponująca, ale nie zawsze pewna. AI czasem pomyli gatunek kwiatów… albo co gorsza etykietę leku z czymś innym. Opisując scenę, może pominąć kluczowe detale. W nawigacji nie zawsze wyłapie nagłą przeszkodę, jak wystający kabel czy krawężnik. Efekt? Niewidomi traktują AI jak asystenta, ale trzonem wciąż są laska czy pies przewodnik. Poprawa precyzji i wyczucia kontekstu to wyzwanie, nad którym inżynierowie i naukowcy ciągle pracują

Niektóre zadania to dla AI mur. Zgubiłeś długopis w pokoju? Telefon ci go nie znajdzie, bo nie skanuje aktywnie otoczenia, musisz sam trafić kamerą. Badania pokazują, że szukanie zgub to wielka bolączka niewidomych w domu. A co z obsługą sprzętów? Mikrofale czy drukarki z ekranami dotykowymi to koszmar. Są do tego aplikacje jak VizLens, ale to kropla w morzu. Odręczny tekst, jak na kartce urodzinowej lub recepcie, też często przerasta AI.

Integracja kuleje. Użytkownicy żonglują apkami - jedna do czytania, druga do nawigacji, trzecia do trudniejszych spraw. Przełączanie męczy. Idealnie AI powinno połączyć wszystko w jednym miejscu, ale na razie to galimatias. Do tego narzędzia nie zawsze grają z tym, co niewidomi już mają - mentalnymi mapami czy oznaczeniami. Badania mówią, że to frustruje i zniechęca do używania. AI musi być elastyczne, a nie narzucać swoje.

Nauka obsługi też nie jest prosta. Smart-laska czy ekran z AI to nie plug-and-play. Trzeba nauczyć się gestów, komend, kalibracji. Jak interfejs nie jest intuicyjny, to te wszystkie funkcje nie są przydatne. Aktualizacje czasem psują dostępność stron internetowych i aplikacji - przesunięty przycisk i czytnik ekranu głupieje. Nie każdy wie o nowych rozwiązaniach, a starsi użytkownicy często odpadają. Koszt smart-okularów czy nawet dobrego telefonu to bariera.

Prywatność i społeczność też nie pomagają. Noszenie kamery w okularach budzi pytania: “co nagrywasz?” Wysyłanie zdjęć do chmury niesie ryzyko przecieku danych.

Nie każdy chce oddać wszystko AI. Wolą człowieka, który w muzeum odpowie na spontaniczne pytanie, zamiast suchego opisu z apki. AI jeszcze brakuje tej ludzkiej iskry…chociaż to jest subiektywne. Dzisiejsze modele głosowe w ChatGPT, Grok, Gemini, Elevenlabs nie są takie złe!

Nowe kierunki i innowacje

Technologia dla niewidomych pędzi naprzód, napędzana AI, które coraz lepiej łączy obraz, język i kontekst. Co się rodzi na horyzoncie? Coś, na co niewidomi czekają.

Multimodalne AI to nowa fala. GPT-4o, które widzi i rozmawia, już działa w Be My AI. Wysyłasz zdjęcie, dostajesz opis i możesz dopytać: „Czy to mój znajomy? Co jest na slajdzie?”. Envision wrzuca GPT do swoich okularów, a Grok czy ChatGPT dają głosowego asystenta na zawołanie. Wyobraź sobie: nosisz kamerę, a AI szepcze ci na bieżąco, co się dzieje - „Tomek jest po lewej, prezentacja mówi o AI”. Siri czy Alexa z dużymi modelami językowymi mogą wkrótce ogarniać bardziej skomplikowane prośby, z wyczuciem sytuacji. Alexa+ z AI już debiutuje w USA, o czym możesz przeczytać tutaj.

Wearables idą dalej. Biped to coś jak „laska na klatce piersiowej”. Kamery na klatce piersiowej wykrywają przeszkody od stóp po głowę. AI Guided to pasek, który jest Twoimi oczami. Gdzie indziej rodzą się robo-przewodnicy. W USA i UK testują psy czy wózki z AI, które słuchają komend i omijają przeszkody. To jeszcze prototypy, ale ambitne. Haptics też rośnie, Sunu Band wibrują na przeszkodę, a przyszłe wersje z AI mogą rozróżniać, co jest czym, i kierować Cię lepiej.

W domu i w kontekście. Nawigacja w pomieszczeniach to ból. AI zaczyna to łatać. Seeing AI marzy o „World Seeing AI”, które oznaczy miejsca w pokoju. Rozwój idzie w wizję 3D, kamera buduje model otoczenia i mówi: „Drzwi na lewo, krzesła w środku, idź w prawo”. To już niekoniecznie wymaga chmury, tylko mocniejszych procesorów w telefonach.

Treść na nowo. AI może rozpracować wykresy czy infografiki. IIT i Microsoft testują systemy, które opiszą je dźwiękiem albo dotykiem. MIT buduje Umwelt, gdzie niewidomi sami tworzą dane interaktywnie. Wideo też się zmienia. AI może automatycznie opisywać filmy czy wydarzenia na żywo - sprawdź aplikację Gemini, w której model procesuje obraz i dźwięk z filmów na Youtube.

Przyszłość? AI, które rozmawia, rozumie i przewiduje. Okulary, które wyglądają normalnie, ale szepczą: „Klucze na blacie” albo „ten gość wygląda na zdziwionego” lub “Twój przyjaciel Piotrek stoi przed Tobą”. Multimodalne systemy już są budowane. Widzą, słuchają, uczą się Twoich nawyków. Od prostego czytania tekstu do towarzysza, który czuje kontekst. Z firmami, startupami i społecznością w grze, AI może naprawdę zdjąć bariery i dać wolność. Pytanie tylko: jak szybko to nadejdzie?

👩🏻💻🛒 AI w e-commerce, czyli czym jest FeedGen i jak może pomóc Twoim plikom produktowym

Czym jest FeedGen?

FeedGen to narzędzie oparte na sztucznej inteligencji, zaprojektowane głównie z myślą o optymalizacji feedów produktowych w branży e-commerce. Jego głównym celem jest poprawa jakości danych w plikach produktowych, takich jak tytuły, opisy czy atrybuty produktów, co przekłada się na skuteczniejsze kampanie reklamowe, np. w Google Ads.

FeedGen wykorzystuje zaawansowane modele AI, takie jak Vertex AI od Google, do automatycznego generowania bardziej precyzyjnych i atrakcyjnych tytułów produktów, uzupełniania brakujących informacji czy tworzenia szczegółowych opisów. Może również analizować istniejące dane w feedzie i proponować ulepszenia, dostosowane do indywidualnych potrzeb użytkownika.

Co ciekawe, dzięki integracji z technologiami jak Gemini, FeedGen potrafi analizować także zdjęcia produktów, wyodrębniając z nich dodatkowe cechy, np. kolor czy styl, co jeszcze bardziej wzbogaca dane.

Narzędzie to jest szczególnie przydatne dla właścicieli sklepów internetowych i marketerów, którzy chcą zwiększyć skuteczność reklam, poprawić wskaźniki takie jak CTR czy CR, a także obniżyć koszty kampanii - CPC. FeedGen działa w sposób zautomatyzowany, oszczędzając czas i eliminując konieczność ręcznej edycji dużych ilości danych.

Kluczowe informacje wprowadzające:

Plik produktowy to podstawa reklamy produktowej

Jest to lista produktów z informacjami o nich (np. tytuł, cena, dostępność). Na podstawie tego pliku systemy reklamowe decydują, komu i jakie reklamy wyświetlać.

Poprawnie uzupełniony plik zwiększa szanse na lepszą widoczność i skuteczność reklam.Optymalizacja pliku produktowego zwiększa efektywność reklam

Tytuły produktów powinny być jasne, zwięzłe, ale szczegółowe (np. marka, model, rozmiar, kolor).

Opis jest równie istotny – dostarcza algorytmom dodatkowych informacji, nawet jeśli nie jest widoczny dla użytkownika.

Uzupełnianie atrybutów (np. płeć, materiał, technologia) poprawia jakość feedu i widoczność reklam.

Jak korzystać?

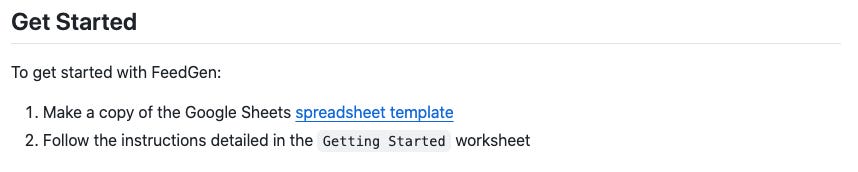

Wejdź na 🔗 GitHub projektu, scrolluj do sekcji “Get Started” i otwórz umieszczony tam link, aby stworzyć kopię arkusza kalkulacyjnego FeedGen - o tutaj 👇🏻

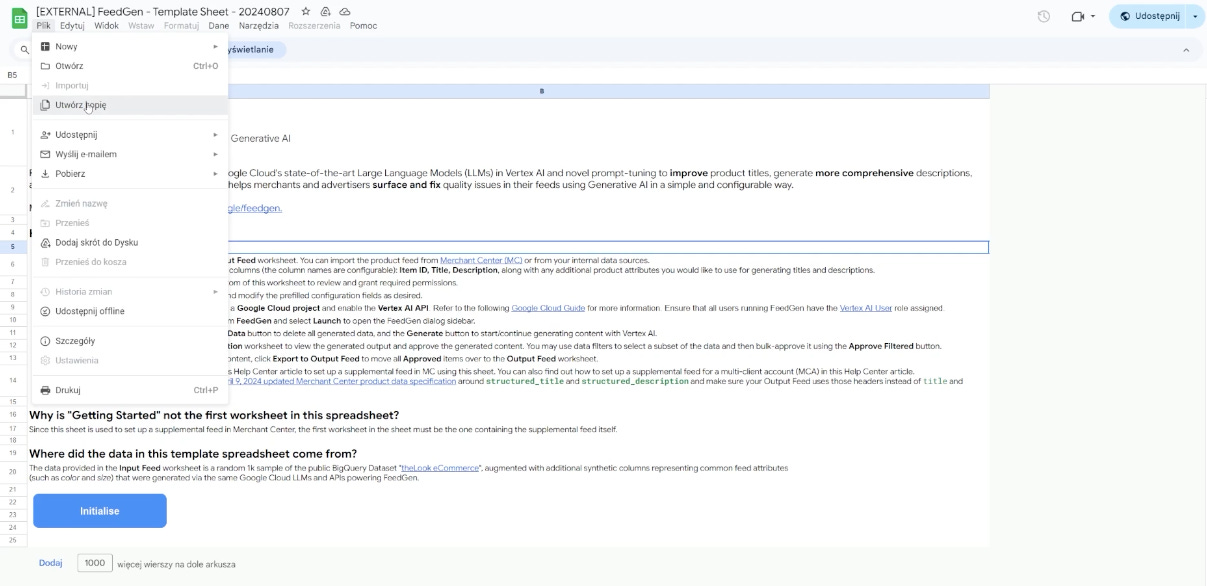

Następnie utwórz swoją własną kopię tego pliku:

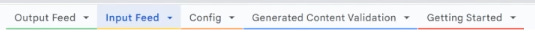

W stworzonym pliku zerknij na zakładki na dole i zacznij od ostatniej na liście - “Getting Started”…

…a następnie w oknie instrukcyjnym kliknij button “Initilaise”, aby uruchomić panel do zarządzania FeedGen w Twoich arkuszach produktowych (musisz zalogować się na swoim koncie Google Claude Platform lub je stworzyć*). Panel odpalisz klikając button FeedGen w menu arkusza, a wygląda on tak:

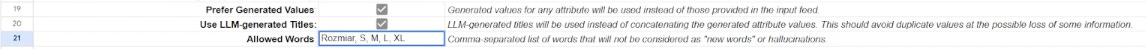

Następnie wklejasz swoją listę produktów w zakładce “Input Feed”, a później przechodząc do zakładki “Config”, konfigurujesz swoją listę produktową określając odpowiednio nazwy komórek oraz zaznaczając ✅ które akcje ma wykonać FeedGen automatycznie:

❗️Uwaga ❗️ Chociaż sam dostęp - uruchomienie czy konfiguracja FeedGen jest darmowe, to za część operacji możesz zapłacić. Nie są to wygórowane koszty, ale musisz o tym wiedzieć. Dla przykładu, za poprawienie feedu produktowego na 1000 produktów, koszt to ok. $0.36. Jak widzisz wyżej na rycinie - szara komórka - estymowany koszt żądanych operacji możesz na bieżąco śledzić, więc masz nad tym kontrolę, a kwota jaką wyliczysz jest raczej śmieszna… noooo! chyba, że prowadzisz hurtownię elektrotechniczną z 100.000 produktów.

Aby w pełni skonfigurować swój plik produktowy, musisz stworzyć projekt dla FeedGen w Google Claude oraz uruchomić tam Vertex AI API (linki znajdziesz w samouczku, który otwierałeś w kroku 2):

skopiuj identyfikator projektu Google Claude, który założyłeś pod tworzenie pliku produktowego w FeedGen

Włącz Vertex AI API

Nadaj dostępy użytkownikom, którzy będą korzystać z naszego arkusza z produktami

Następnie wracasz do zakładki “Config” i wklejasz tam ID projektu, ustawiasz model AI z jakiego chcesz korzystać i język w jakim wykonany będzie plik (domyślnie jest j.angielski, ale w naszym wypadku powinniśmy ustawić j.polski).

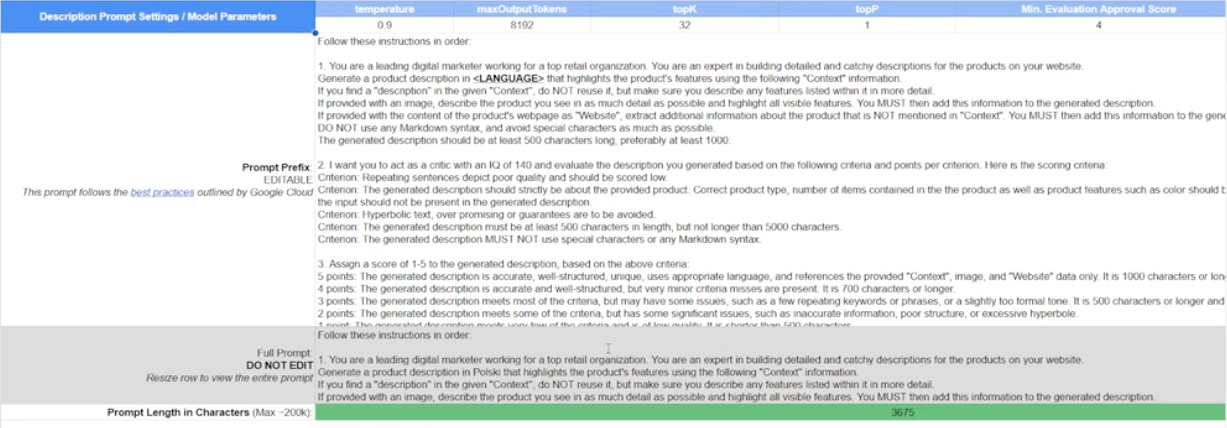

I teraz 🍒 czyli ustawienie kreatywności FeedGen i prompta, na podstawie którego będzie wykonywał akcje:

tworzenie opisu produktu

tworzenie tytułu

Należy wykonać to oczywiście wg. najlepszych praktyk promptowania. Pomóc Wam może w tym np. nasz 🔗 generator promptów, ale generalnie chodzi o to, aby poinstruować FeedGen, aby ten wcielił się w rolę specjalisty od e-commerce, który potrafi tworzyć interesujące opisy produktów zgodnie z najlepszymi wzorcami - oraz w oparciu o kontekst, który też uzupełniamy w tym samym oknie.

Warto przerobić tę systemową instrukcję (choć oczywiście możesz ją tylko przetłumaczyć), na naszą-indywidualną, zgodną z oczekiwaniami, charakterystyką sprzedawanych produktów, branży i grupy do której chcemy dotrzeć.

Ustaw też ✅ na tych opcjach:

Pamiętaj, że FeedGen nie działa z próżni. Musisz choćby odrobinę się zaangażować i dać wskazówki AI, aby mogła wiedzieć na czym Ci zależy. Przygotuj więc dwa lub trzy produkty do pliku produktowego solidnie z opisami, tytułami, charakterystyką i innmi potrzebnymi atrybutami, aby dać kontekst, z którego korzysta AI do generacji perfekcyjnych opisów czy tytułów dla Twoich produktów.

To jak efektywnie zadziałał FeedGen na podstawie Twojego promptu i ustawień sprawdzić możesz w zakładce “Validation” - zobaczysz tam co i jak zostało zmienione i ocenisz w porównaniu do poprzedniej wersji wartość tych zmian.

Po tym jak porównasz i ocenisz poprawność generacji, wyeksportuj ją do “Output Feed” klikając button na panelu FeedGen.

Ostatnią rzeczą jest dodanie pliku do naszego Google Merchant Center.

zanim go wgrasz, musisz oznaczyć w pliku, że został wygenerowany przez AI

I voila! Widoczność Twoich kampanii produktowych wzrasta! Pobawcie się tym narzędziem, a zobaczycie jak bardzo pójdziecie w górę Wasza skuteczność

*Nie mogłem rozwlec tego instruktarzu jeszcze na Google Claude Platform zakładając, że wiesz czym jest. Jednak jeśli chcesz, napisz do nas, a prześlemy Ci odpowiedni instruktaż.

🥡 AI na Wynos - nowości AI

🚗 Volvo dba o bezpieczeństwo wykorzystując AI - czytaj

👨🏻🎓Sztuczna inteligencja w szkole to pułapka. "Zamiast się uczyć, oszczędzamy czas". Przemyślenia z sali lekcyjnej - czytaj

🎨 Nowa aktualizacja Midjourney V7 zapewnia szybsze renderowanie, większy realizm i pełną kompatybilność z sref - czytaj

📸 Znasz profil “Sztuczna Polska” na IG? Przeczytaj wywiad z autorem - czytaj

💃 Doda vs. AI. Kampania marketingowa znanej marki - czytaj

⚖️ Jak sztuczna inteligencja wpływa na prawo? - czytaj

👻 Awatar „zeznawał” w Nowym Jorku. „Sąd był naprawdę zdenerwowany” - czytaj

⛪️ „Antiqua et nova” po polsku – prezentacja watykańskiego dokumentu o AI - czytaj

🤖 Czy chcemy być informowani, ze reklamę wygenerowała AI? - czytaj

🎤 Do czego młodzież wykorzystuje AI - posłuchaj sondy ulicznej

⚽️ VAR a sztuczna inteligencja - czytaj

🚂 AI pomoże polskiej kolei? - czytaj

🏭 Sztuczna inteligencja do spalania śmieci. Pierwszy taki system w Polsce - czytaj

📬 Czytałeś/-aś wydanie z 02.04? Treść “AI zna historię Twojej rodziny 👵🏻🌳👴🏻

🔠 Wymiatacz do generowania tekstów 🎉 Festiwal umiejętności AI 📆 Prawnicze wydarzenie roku 💼 AI Jobs” - trafiła na Twój mail w minioną środę. Sprawdź skrzynkę.

“AI in action: Empowering people with disabilities through technology” | IBM Fellow: Chieko Asakawa

Chieko opowiada o tym jak straciła wzrok oraz o tym nad czym dzisiaj pracuje - wózkiem z AI, który ma pomóc niewidomym.AI-powered brain chip turns thoughts into action for people with physical disabilities

Chip, dzięki któremu niepełnosprawni mogą wykonywać akcje w wirtualnej rzeczywistości - VR.

Dzięki za przeczytanie tego wydania newslettera Horyzont AI!

- @MarcinUszyński @JakubNorkiewicz

Jeśli jesteś tu pierwszy raz - dołącz za darmo, aby regularnie otrzymywać takie treści na swojego maila.

A jeśli już jesteś subskrybentem i dotarłeś tutaj, oceń treść:

Jeżeli chcesz słuchać treści newsletterów w formie audio, to subskrybuj nasz kanał youtube - gorąco zachęcamy!

Wielkie ❤ za część o wsparciu niewidomych/niedowidzących.