AI: Co działa dziś, a co było hitem wczoraj?

🤫 Google Gemini AI Pro na 15 miesięcy za DARMO! Tylko dla czytelników newslettera!

🔉Wolisz wersję audio? Nie możesz przeczytać teraz maila?

Przesłuchaj tutaj

Możesz nas słuchać także na Apple Podcast i Spotify.

🎯 W DZISIEJSZYM WYDANIU

🎓 AI od zera do zrozumienia: 🌪 Tempo zmian w AI

🛠 AI w praktyce: Jak odebrać pakiet Gemini AI Pro na 15 miesięcy za darmo?

🥡 AI na Wynos:

🎪 Błąd Mety.

🇨🇳🧳 Kreatywna odpowiedź na amerykańskie restrykcje eksportowe

🤖 Anthropic ujawnia kulisy budowy systemu multi-agentowego:

🦾 Meta prezentuje V-JEPA 2 - nowy model świata, który rozumie i przewiduje działania wideo, a nawet umożliwia…

💰 Meta inwestuje 14,3 mld dolarów w Scale AI i powołuje zespół „Superintelligence”

🎥 Showrunner to nowa platforma AI od Fable Simulation

🤖 OpenAI wprowadza „Best-of-N” do Codexa

🤖 Historyczny przełom: autonomiczny dron TU Delft

🇬🇧 Brytyjski rząd oficjalnie wspiera wykorzystanie generatywnej AI w edukacji

🧩 MASS (Multi-Agent System Search)

🛡️ Nowa praca „Design Patterns for Securing LLM Agents against Prompt Injections”

📚 Rekomendowana Biblioteka:

Kojima, T., Gu, S. S., Reid, M., Matsuo, Y., & Iwasawa, Y. (2022). Large Language Models are Zero-Shot Reasoners. arXiv:2205.11916. https://arxiv.org/abs/2205.1191

Meincke, L., Mollick, E. R., Mollick, L., & Shapiro, D. (2025). Prompting Science Report 2: The Decreasing Value of Chain of Thought in Prompting. SSRN. https://ssrn.com/abstract=5285532

Tempo zmian w AI

W przypadku AI jest tak, że ledwo się czegoś nauczysz, a ta wiedza szybko staje się nieaktualna w ciągu kilku dni, tygodni czy miesięcy.

Ostatnio przeglądałem swoje notatki sprzed roku. Pełno tam wskazówek typu "zawsze dodawaj 'think step by step' do promptów" czy "Claude 3 Opus jest najlepszy w kreatywnym pisaniu". Dziś? Połowa z nich to już archeologia. Modele się zmieniły, pojawiły się nowe, a stare triki czasem działają gorzej niż nicnierobienie.

To trochę jak z żartem o JavaScript - "wychodzisz na weekend, a w poniedziałek połowa twojego stacku technologicznego jest przestarzała".

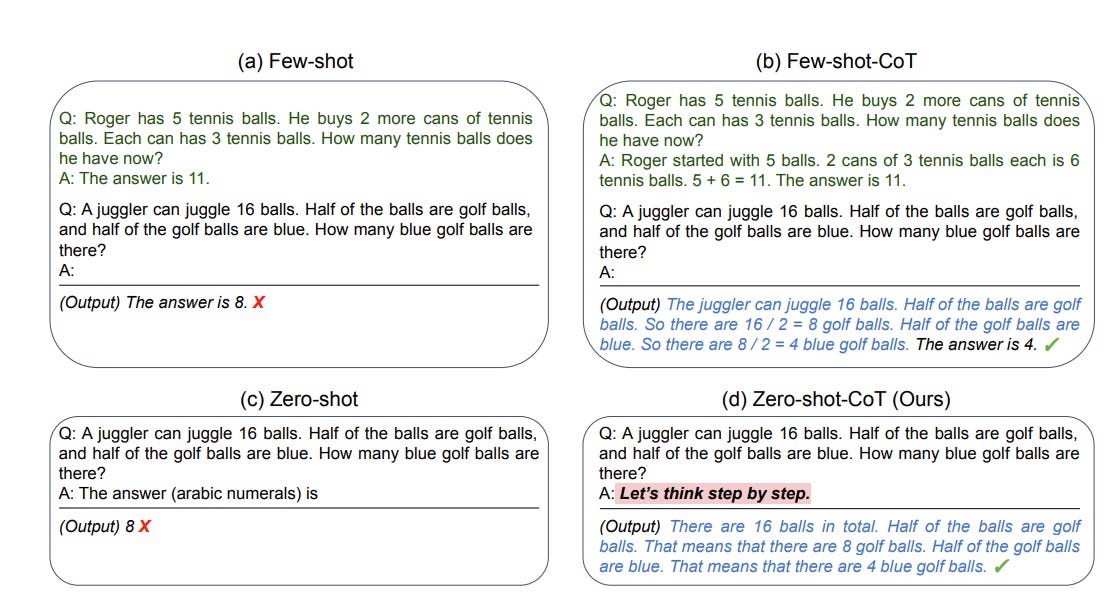

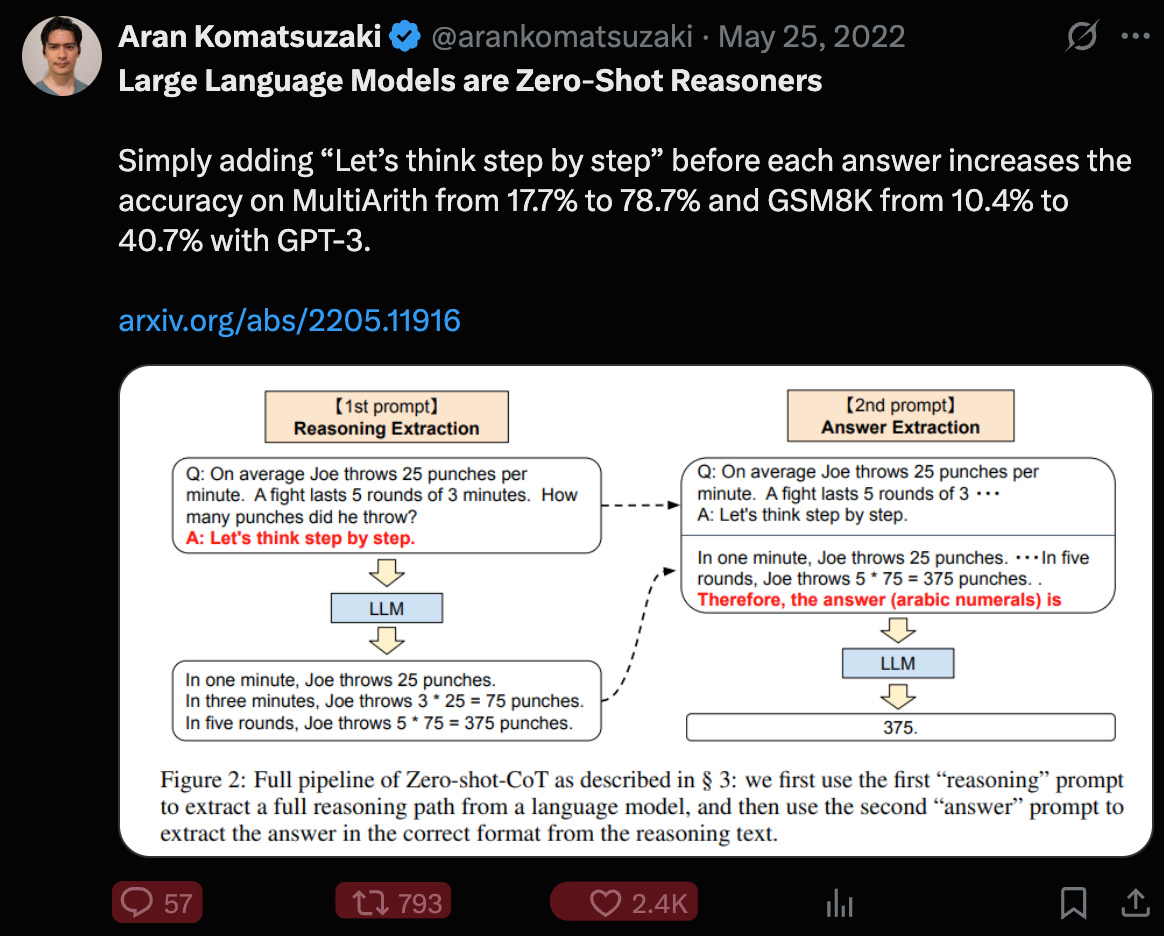

Weźmy konkretny przykład. W styczniu 2023 roku naukowcy odkryli, że wystarczyło dodać do prompta "Let's think step by step" i nagle modele językowe stawały się dramatycznie lepsze w rozwiązywaniu zadań matematycznych. Z 17% skuteczności na 78%. Magia.

Minęły dwa lata. Ethan Mollick z Wharton właśnie opublikował badanie, które pokazuje, że ta magia przestaje działać. Co więcej - w niektórych przypadkach może nawet szkodzić.

Ale to nie jest tekst o porażce AI. To tekst o tym, jak szybko ewoluuje AI i dlaczego warto śledzić najnowsze badania. Bo to, co dziś jest przełomem, jutro może być już tylko ciekawostką historyczną.

Styczeń 2023: Odkrycie “think step by step”

Takeshi Kojima i jego koledzy mieli prosty pomysł - co się stanie, jeśli zamiast od razu pytać model o odpowiedź, poprosimy go najpierw o... przemyślenie sprawy?

Brzmi banalnie? Wyniki były wszystkim, tylko nie banalne.

Weźmy konkretny przykład z ich badania.

Standardowe podejście (pytasz → dostajesz odpowiedź):

Skuteczność na zbiorze zadań MultiArith (zbiór zadań, które testują zdolności arytmetyczne modeli AI): 17.7%

Podejście z "Let's think step by step":

Skuteczność na tym samym zbiorze: 78.7%

Widzisz różnicę? To jak przeskoczyć z oceny dopuszczającej na czwórkę z plusem (piątka jest chyba od 80% poprawnych zadań, z tego co pamiętam z lat szkolnych). Jednym prostym zdaniem.

Na trudniejszym zestawie zadań GSM8K (zadania matematyczne na poziomie szkoły podstawowej) skok był z 10.4% na 40.7%. To czterokrotna poprawa!

Ale dlaczego to działa?

Model językowy, gdy poprosisz go o natychmiastową odpowiedź, zachowuje się jak uczeń strzelający na chybił trafił. Ale gdy dodasz "Let's think step by step", zmuszasz go do pokazania całego rozumowania. To tak, jakbyś poprosił model o rozpisanie działania na tablicy, a nie zgadywanie wyniku.

Co ciekawe, to działało praktycznie na wszystkim - matematyce, zadaniach logicznych, nawet rozumowaniu symbolicznym. Kojima nazwał to "Zero-shot Chain of Thought" (Zero-shot-CoT), bo nie potrzebowałeś żadnych przykładów. Wystarczyło magiczne zdanie “myśl krok po kroku”.

Społeczność AI oszalała. Wreszcie prosty, uniwersalny sposób na poprawę wyników. Dodajesz jedno zdanie i voilà - Twój model staje się mądrzejszy.

Czerwiec 2025: Mollick burzy mit

Dwa lata później. Ethan Mollick publikuje badanie, które brzmi jak sequel badania Kojimy - "The Decreasing Value of Chain of Thought in Prompting". Tytuł mówi wszystko.

Ale zanim zaczniemy narzekać, że kiedyś to było, spójrzmy na to jak na naturalną ewolucję. Pamiętasz, jak uczyłeś się jeździć na rowerze? Na początku kółka boczne były niezbędne. Bez nich - gleba. Ale z czasem nauczyłeś się trzymać równowagę i kółka stały się zbędne.

Dokładnie to samo stało się z "Let's think step by step".

Mollick i jego zespół przetestowali różne modele na zestawie GPQA Diamond - brutalne pytania na poziomie doktoratu z fizyki, chemii i biologii. Te, przy których nawet eksperci osiągają tylko 69.7% skuteczności, nawet mając nieograniczony dostęp do internetu.

Co odkryli?

Dla standardowych modeli (Sonnet 3.5, GPT-4o, Gemini):

CoT dalej pomaga, ale już nie tak dramatycznie

Czasem nawet szkodzi - modele zaczynają "przemyślać" i gubią się we własnym rozumowaniu

Gemini Flash 2.0 z CoT miał GORSZĄ skuteczność w zadaniach, które normalnie rozwiązywał bezbłędnie

Dla modeli "reasoning" (o3-mini, o4-mini, Flash 2.5):

Poprawa? Marginalna. Mówimy o 2-3 procentach

Czas odpowiedzi? Dłuższy o 20-80%

Koszty? Dużo wyższe

Wiesz dlaczego CoT przestaje działać? Bo nowe modele już myślą krok po kroku bez proszenia.

Mollick pokazał to w prosty sposób - kazał modelom odpowiadać "bez myślenia, tylko podaj odpowiedź". I co? Modele i tak rozpisywały rozumowanie.

Co więcej, wymuszanie "prostej odpowiedzi" często POGARSZAŁO wyniki. Model chce rozpisać rozumowanie, ty mu nie pozwalasz, więc strzela. I pudłuje.

To nie porażka Chain of Thought. To sukces. Technika była tak dobra, że została wbudowana w DNA nowych modeli. Nie musisz już prosić modelu, żeby myślał krok po kroku. On już to robi.

Ale czy to oznacza, że możemy wyrzucić CoT do kosza?

Co się zmieniło w modelach AI

Modele AI przeszły coś w rodzaju okresu dojrzewania.

Mollick w swoim badaniu pokazał to czarno na białym. Kiedy poprosił modele o odpowiedź "bez dodatkowych wyjaśnień", większość i tak zaczęła od rozpisania rozumowania.

Spójrzmy na konkretne liczby:

Wpływ CoT na różne typy modeli (GPQA Diamond)

Modele standardowe:

Sonnet 3.5: +11.7% średniej skuteczności z CoT

Gemini Flash 2.0: +13.5% średniej skuteczności

GPT-4o: +7.2% średniej skuteczności

GPT-4o-mini: +4.4% średniej skuteczności (nieistotne statystycznie)

ALE - i tu jest haczyk. Mollick nie zadawał każdego pytania raz. Zadawał je 25 razy.

Kiedy mierzysz "perfekcyjną dokładność", patrzysz które pytania model rozwiązał poprawnie za każdym razem - 25 na 25 prób. Zero pomyłek.

Gemini Flash 2.0: -13.1% (tak, MINUS!)

Gemini Pro 1.5: -17.2% (jeszcze gorzej!)

Co to oznacza? CoT sprawia, że model częściej zmienia zdanie. Zadanie, które bez CoT rozwiązywał konsekwentnie dobrze 25/25 razy, z CoT może rozwiązać np. 23/25 razy dobrze i 2 razy źle. Średnio wychodzi lepiej, ale już nie jest perfekcyjnie.

Modele "reasoning" (nowa generacja):

o3-mini: +2.9% (ledwo zauważalne)

o4-mini: +3.1% (marginalne)

Gemini Flash 2.5: -3.3% (pogorszenie!)

Koszty ukryte

Tu jest prawdziwy problem. CoT to nie tylko "dodaj jedno zdanie":

Dla modeli z reasoningiem różnice są mniejsze, ale nadal znaczące, np. wypadają 20-80% dłużej w czasie odpowiedzi.

Wyobraź sobie, że obsługujesz tysiące zapytań dziennie. To różnica między rachunkiem 1000 zł a 5000 zł. Za marginalną (albo żadną) poprawę.

Ewolucja w praktyce

Mollick pokazał też coś ciekawego. Porównał odpowiedzi modeli na to samo pytanie:

Pytanie: "A juggler can juggle 16 balls. Half of the balls are golf balls, and half of the golf balls are blue. How many blue golf balls are there?"

Model bez żadnej instrukcji: Automatycznie rozpisuje: "Jest 16 piłek. Połowa to piłki golfowe, czyli 8. Połowa piłek golfowych jest niebieska, czyli 4."

Ten sam model z promptem "odpowiedz bezpośrednio": "8" (błąd!)

Widzisz paradoks? Model "wie" jak rozwiązać zadanie, ale gdy zabraniamy mu myśleć, gubi się.

To jak ewolucja świadomości w modelach AI. Kiedyś musiałeś je uczyć myślenia*. Teraz musisz uważać, żeby im w tym myśleniu nie przeszkadzać.

*myślenie - to słowo w kontekście modeli AI zbiera sporo krytyki. Osobiście wolę nazywać to optymalizacją odpowiedzi. Jeśli czytałeś poprzednie wydanie newslettera, wiesz już, że w niektórych przypadkach odpowiedź na dane pytanie jest już "zakodowana" w modelu. Myślenie (czyli Chain of Thought) pomaga modelowi dotrzeć do tej odpowiedzi bardziej precyzyjnie i systematycznie.

Co to oznacza dla nas i dokąd zmierza AI

Dobra, czas na praktyczne wnioski. Co robić z tą wiedzą?

Dla osób nietechnicznych: Jeśli używasz ChatGPT czy Claude do codziennych zadań, możesz spokojnie zapomnieć o "Let's think step by step". Nowe modele już to robią. Pisz naturalnie, jasno formułuj pytania. To wystarczy.

Dla programistów i power userów: Historia jest bardziej skomplikowana.

Kiedy CoT może jeszcze pomóc:

- Używasz starszego modelu (GPT-3.5, starsze wersje Claude)

- Pracujesz z mniejszymi, open-source modelami

- Zadanie jest naprawdę skomplikowane i wieloetapowe

- Chcesz zobaczyć rozumowanie modelu (debugging)

Kiedy CoT może zaszkodzić:

- Używasz modeli "reasoning" (o1, o3, nowe wersje Gemini)

- Liczy się szybkość odpowiedzi

- Płacisz za tokeny (pamiętaj o 2-5x kosztach!)

- Zadanie jest relatywnie proste

Złota zasada: Testuj na swoich promptach. To, co działa dla Mollicka na zadaniach z fizyki kwantowej, może nie działać dla Twoich e-maili marketingowych.

Ale jest tu większa lekcja.

Pamiętasz początek tego tekstu? O tym, jak szybko wiedza o AI się dezaktualizuje? Ta historia z CoT to idealny przykład. W styczniu 2023 to był przełom. W czerwcu 2025 to już tylko ciekawostka historyczna dla nowych modeli.

Wyobraź sobie, gdzie będziemy za kolejne dwa lata. Może promptowanie w ogóle zniknie? Może modele będą tak dobre w rozumieniu intencji, że wystarczy pomyśleć, czego chcesz? (Ok, może przesadzam, ale kto wie?)

Morał jest prosty:

1. Śledź badania

2. Testuj nowe podejścia

3. Nie przywiązuj się do "sprawdzonych metod" (bo sprawdzone dzisiaj = przestarzałe jutro)

I najważniejsze - eksperymentuj. Bo w świecie, gdzie tricki z AI tracą moc co dwa lata, umiejętność adaptacji jest prawdziwą przewagą.

Na marginesie, sam Kojima (autor oryginalnego badania o CoT) pewnie się cieszy. Jego odkrycie było tak dobre, że stało się standardem.

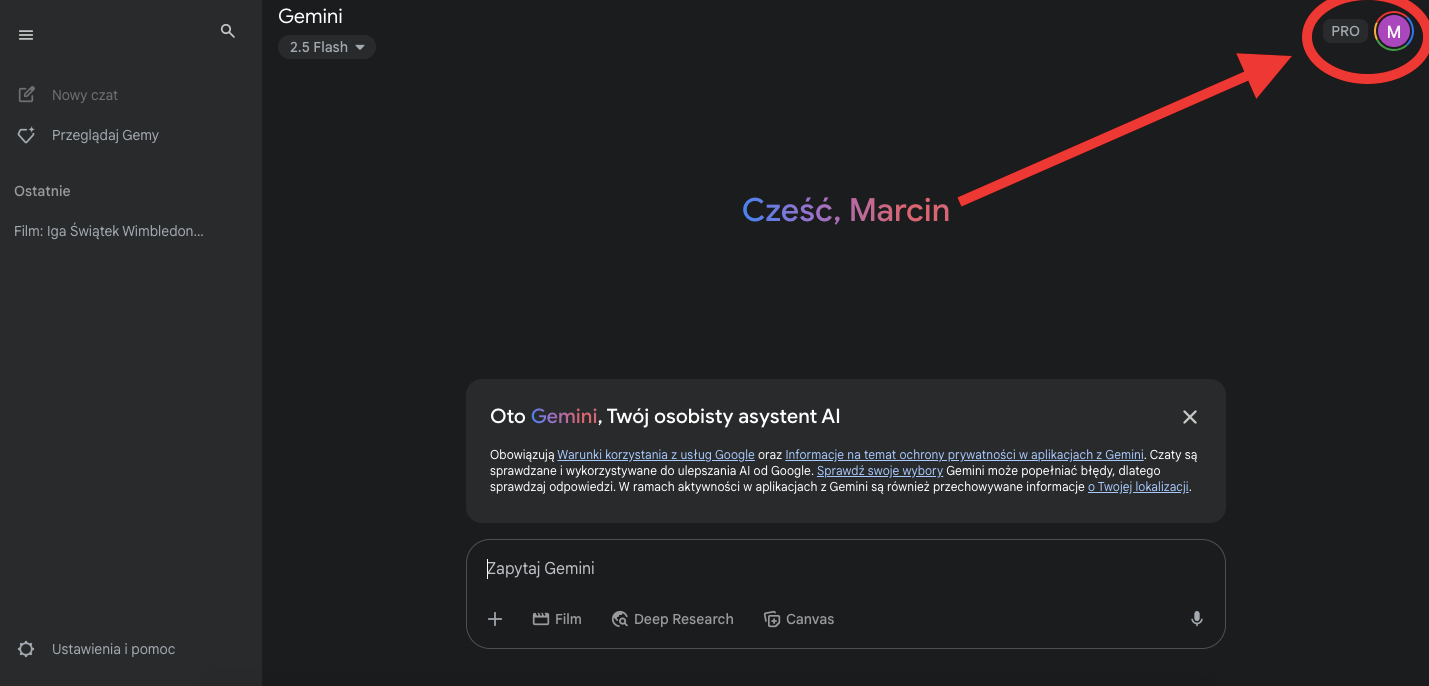

Google otworzyło właśnie bardzo kuszącą promocję dla swojej usługi Gemini AI Pro dla studentów, którzy absolutnie za darmo otrzymują dostęp na ponad rok np. do NotebookLM, Whisk, 2 TB bezpłatnej pamięci masowej. Problem w tym, że promka trwa tylko do 30.06, a rejestracji dokonać mogą tylko studenci w wybranych krajach.

Mamy jednak na to sposób… 😏

Jak odebrać pakiet Gemini AI Pro na 15 miesięcy za darmo?

Jeśli chcesz dostęp do całego wachlarza możliwości sztucznej inteligencji od Google absolutnie za darmo musisz:

Założyć wirtualną kartę kredytową - zrobisz to np. w Revolut (subskrypcja nie obciąży Twojego konta, więc założenie karty ma charakter jedynie techniczny)

Założyć tymczasowy adres mailowy z końcówką .edu - zrobisz to np. tutaj i nie zamykaj okna skrzynki odbiorczej.

Założyć nowe konto Google na potrzebę korzystania z Gemini AI Pro

Następnie:

Zainstaluj SetupVPN, które jest dostępne jako rozszerzenie dla przeglądarki Chrome (będziesz miał godzinę, bo SetupVPN ma limit 60 minut działania. Czas do końca będzie widoczny na zegarze)

Ustaw połączenie z 🇺🇸 USA a w ustawieniach rozszerzenie w Chrome „zezwalaj w trybie incognito”

Zaloguj się na nowo utworzone konto Google

Otwórz okno incognito w przeglądarce Chrome i przejdź na: one.google.com/join/ai-student

Podczas rejestracji wpisz mail z końcówką edu, który utworzyłeś. Na skrzynkę otrzymasz kod weryfikacyjny, który potwierdzi Twoją tożsamość.

Następnie dodaj metodę płatności. W moim przypadku była to karta wirtualna (np. Revolut) z adresem ustawionym na USA. W miejscu kodu pocztowego wpisałem 10001 (New York)

I voila! Miłego wykorzystania potencjału AI od Google.

PS. Pamiętajcie, że 15 września 2026 roku Google będzie chciał obciążyć Wasze konto - jednak dopiero wtedy! Wcześniej korzystacie z usług za darmo.

🥡 AI na Wynos - nowości AI

🎪 Błąd Mety. Rozmowy użytkowników z ich modelami są publicznie dostępne. Możesz się dowiedzieć kto i o co zapytał model. Wycieki są tragiczne. → czytaj

🇨🇳🧳 Chińscy inżynierowie przewieźli do Malezji walizki z 4,8 PB danych na twardych dyskach, by trenować modele AI na wynajętych serwerach z chipami Nvidii - kreatywna odpowiedź na amerykańskie restrykcje eksportowe. → czytaj więcej

🤖 Anthropic ujawnia kulisy budowy systemu multi-agentowego: Claude Research korzysta z wielu agentów, którzy równolegle przeszukują sieć i integracje, by szybciej i skuteczniej odpowiadać na złożone pytania. Nowa architektura to lekcja z planowania, podziału zadań i prompt engineeringu. → czytaj więcej

🦾 Meta prezentuje V-JEPA 2 - nowy model świata, który rozumie i przewiduje działania wideo, a nawet umożliwia robotom planowanie zadań w nieznanych środowiskach bez wcześniejszego treningu. 1,2 mld parametrów i nowe benchmarki do oceny rozumowania fizycznego. → sprawdź

💰 Meta inwestuje 14,3 mld dolarów w Scale AI i powołuje zespół „Superintelligence” - do firmy dołącza Alexandr Wang (założyciel Scale), by pomóc Markowi Zuckerbergowi w walce o dominację w AI. Meta oferuje nawet 10 mln $ rocznie, by przyciągnąć topowych badaczy, ale konkurencja o talenty jest rekordowo ostra. → czytaj więcej

🎥 Showrunner to nowa platforma AI od Fable Simulation, która pozwala każdemu tworzyć własne animowane seriale. Wystarczy wpisać prompt, by wygenerować odcinek w stylu np. South Park, anime czy Pixara. Użytkownicy mogą oglądać gotowe serie (np. satyryczne “Exit Valley”) lub tworzyć własne sceny i postacie. Showrunner określany jest jako „Netflix AI” i właśnie ruszył w wersji alfa - dostęp przez listę oczekujących. → zobacz

🤖 OpenAI wprowadza „Best-of-N” do Codexa: teraz model generuje kilka rozwiązań jednocześnie dla jednego zadania, co pozwala szybciej porównać i wybrać najlepszy kod. Funkcja dostępna dla użytkowników Pro, Enterprise, Team, Edu i Plus. → czytaj

🤖 Historyczny przełom: autonomiczny dron TU Delft po raz pierwszy pokonał najlepszych pilotów w międzynarodowych zawodach wyścigowych. → zobacz

🇬🇧 Brytyjski rząd oficjalnie wspiera wykorzystanie generatywnej AI w edukacji - zgodnie z nowymi wytycznymi (GOV.UK, aktualizacja 10 czerwca 2025).

—

🧩 MASS (Multi-Agent System Search) to nowe podejście do automatycznej optymalizacji systemów multi-agentowych (multi-agent LLM). Framework składa się z 3 etapów: 1) optymalizacja promptów dla każdego agenta (np. predyktora, debatera, reflektora), 2) wyszukiwanie najlepszej topologii współpracy (czyli jak agenci się ze sobą komunikują), 3) finalny tuning promptów na poziomie całego systemu. Kluczowy wniosek: jakość promptów dla pojedynczych agentów ma większe znaczenie niż sama architektura systemu, a nie każda złożona struktura agentów daje lepsze wyniki – niektóre wręcz pogarszają efektywność. Automatyczne wyszukiwanie (MASS) pozwala odkryć skuteczne topologie agentów, które adaptują się w trakcie optymalizacji. → czytaj

🛡️ Nowa praca „Design Patterns for Securing LLM Agents against Prompt Injections” prezentuje 6 wzorców projektowych, które pomagają zabezpieczać agentów LLM (np. AI z dostępem do narzędzi) przed atakami prompt injection. → czytaj

📬 Czytałeś/-aś ostatnie wydanie ze środy? Szukaj w skrzynce maila pt. tytułem:

“🔗🧠 Pierwsze w Polsce wydarzenie łączące AI, content i technologię.”

Kojima, T., Gu, S. S., Reid, M., Matsuo, Y., & Iwasawa, Y. (2022). Large Language Models are Zero-Shot Reasoners. arXiv:2205.11916. https://arxiv.org/abs/2205.1191

Meincke, L., Mollick, E. R., Mollick, L., & Shapiro, D. (2025). Prompting Science Report 2: The Decreasing Value of Chain of Thought in Prompting. SSRN. https://ssrn.com/abstract=5285532

Inteligentna transformacja biznesu - Franciszek Gieorgiew

Dzięki za przeczytanie tego wydania newslettera Horyzont AI!

- @MarcinUszyński @JakubNorkiewicz

Jeśli jesteś tu pierwszy raz - dołącz za darmo, aby regularnie otrzymywać takie treści na swojego maila.

A jeśli już jesteś subskrybentem i dotarłeś tutaj, oceń treść:

Jeżeli chcesz słuchać treści newsletterów w formie audio, to subskrybuj nasz kanał youtube - gorąco zachęcamy!

Żeby ustawić konto Revolut na adres z USA potrzebny jest SSN lub ITIN, czyli taki TAX number. Przeszedłem całą drogę, by zdobyć GEMINI AI PRO, aż do momentu płatności, gdzie nie mogłem zapłacić wirtualną kartą, ponieważ konto Revolut nie jest zarejestrowane na USA. Jak obejść ten problem?

Po nieudanej próbie zapłaty kartą zablokowano mi dostęp do tej promocji (pewnie system wychwycił próbę ''scamu'').

Jakieś pomysły? Ktoś miał ten problem?