✨ Najlepsze wydarzenie od Google jakie kiedykolwiek miało miejsce

👩🏻🏫 Od jakiego AI kursu zacząć? 👃🏻👌🏻 Prztyczek w nos programistów - Cava code 👨🏻⚖️ Jak nie łamać prawa korzystając z AI?

🔉Wolisz wersję audio? Nie możesz przeczytać teraz maila?

Przesłuchaj tutaj

Możesz nas słuchać także na Apple Podcast i Spotify.

🎯 W DZISIEJSZYM WYDANIU

🎓 AI od zera do zrozumienia: To było najlepsze wydarzenie Google kiedykolwiek.

🛠 AI w praktyce: AI starter pack oraz Kodowanie z Canva

🥡 AI na Wynos:

👦🏻 Dyrektor z Google'a ostrzega nastolatków. „Uczcie się działać z AI”.

🎓 Aż 71% osób, które ukończyły ten kurs wykorzystuje w pracy narzędzia AI.

🩺 Sztuczna inteligencja już diagnozuje, ale odpowiedzialność wciąż spada na lekarza.

🥶 Straszyła i szantażowała pracowników. Najnowsza sztuczna inteligencja Anthropic jest niezwykle potężna.

🙌🏻 Polskie AI, które automatyzuje tłumaczenie języka migowego dla osób niesłyszących.

👁 AI vs zaćma

⚡️Zużycie energii przez AI nawet o 165 procent do 2030 roku.

🗳 Nawet 50% treści w kampanii prezydeckiej jest tworzone przez boty.

📚 Rekomendowana Biblioteka:

Jak nie łamać prawa korzystając z AI? - Mikołaj Chałas

Pierwsza biografia firmy Nvidia

Polecam całe wydanie odtworzyć w aplikacji/na naszej stronie Substack - w ten sposób obejrzysz video bez problemu!

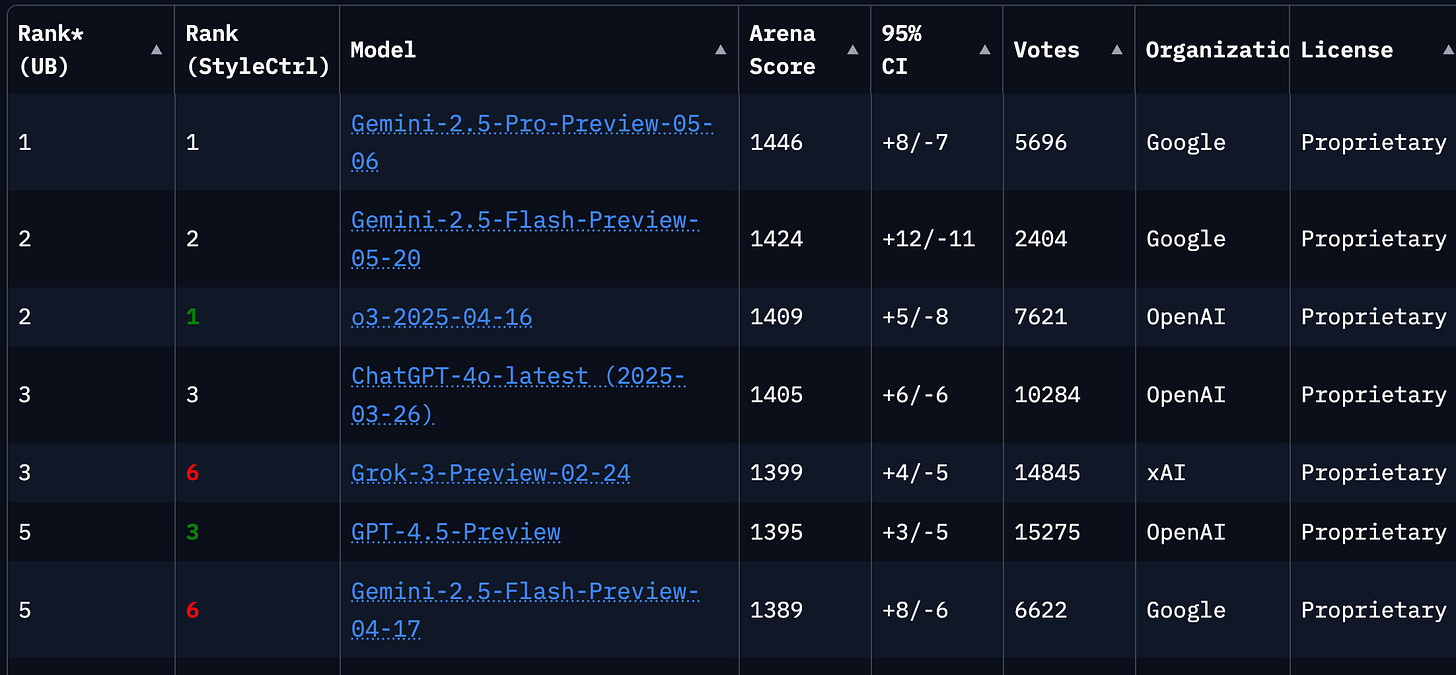

Google jest na szczycie. Teraz jest ich pora. Podium w poniższym rankingu to coś o co ścigają się wszystkie laboratoria tworzące modele AI. Na pierwszym i drugim miejscu są dwa modele od Google. Takiego widoku nie widzieliśmy od dawna. Google w końcu przyśpieszyło, a nawet przegoniło inne firmy.

Ale dzisiaj nie będę pisał o modelach będących na podium. Dzisiaj mam dla Ciebie przewodnik po najważniejszych nowościach od Google zaprezentowanych podczas wydarzenia Google I/O 2025. Dla tych, którzy nie słyszeli o tym wcześniej, jest to coroczne wydarzenie organizowane przez Google, podczas którego firma prezentuje swoje najnowsze osiągnięcia w zakresie technologii, oprogramowania i urządzeń.

Ale wracając do nowości. Jak dla mnie to… tylko chwilowa dominacja Google 😊

To wydarzenie było najlepsze ze wszystkich poprzednich. Już tłumaczę dlaczego👇🏻

Modele AI: Gemini 2.5 (Flash) i Tryb "Deep Think"

Na tegorocznym Google I/O firma mocno podkreśliła rozwój swojej flagowej rodziny modeli sztucznej inteligencji - Gemini. Zaprezentowano najnowszą generację, Gemini 2.5, w dwóch głównych wariantach, oraz nowy tryb myślenia.

Co to jest?

Gemini 2.5 Flash: Mniejszy, ale zoptymalizowany pod kątem szybkości i efektywności model. Idealny do zastosowań, gdzie liczy się krótki czas odpowiedzi, np. w interaktywnych czatach czy szybkich analizach. Google twierdzi, że mimo mniejszego rozmiaru, jego możliwości w wielu zadaniach (np. rozumowanie, kodowanie, multimodalność) są znacznie ulepszone w stosunku do poprzedników.

Tryb "Deep Think": To nowa, zaawansowana funkcja (początkowo dostępna w Gemini 2.5 Pro dla subskrybentów Google AI Ultra), która pozwala modelowi na głębsze i bardziej złożone "przemyślenie" problemu przed wygenerowaniem odpowiedzi. Zamiast szybkiej reakcji, "Deep Think" ma umożliwiać analizę wielu hipotez, rozważanie różnych scenariuszy i bardziej dogłębne badanie tematu.

Jak to działa (koncepcyjnie)?

Wszystkie modele Gemini 2.5 opierają się na architekturze multimodalnej, co oznacza, że potrafią przetwarzać i rozumieć informacje z różnych źródeł jednocześnie - tekst, kod, obrazy, audio i wideo. Google podkreśla również znaczące zwiększenie okna kontekstowego, czyli ilości informacji, którą model może przetwarzać naraz, co pozwala na lepsze rozumienie długich dokumentów, rozmów czy skomplikowanych problemów.

W przypadku "Deep Think", model prawdopodobnie stosuje bardziej złożone techniki rozumowania, być może angażując dodatkowe zasoby obliczeniowe lub specjalne algorytmy do dekompozycji problemu na mniejsze części i iteracyjnego dochodzenia do rozwiązania. Chodzi o to, by AI nie tylko "wiedziało", ale też "rozumiało" na głębszym poziomie.

Co to wnosi?

Ulepszone modele Gemini 2.5 mają napędzać nową falę funkcji AI we wszystkich produktach Google - od wyszukiwarki, przez Workspace.

Dla użytkowników oznacza to potencjalnie bardziej naturalne, szybsze i "inteligentniejsze" interakcje z technologią Google. Asystenci mogą lepiej rozumieć nasze intencje, a narzędzia dostarczać bardziej trafnych i spersonalizowanych wyników.

Tryb "Deep Think" otwiera drzwi do rozwiązywania bardziej skomplikowanych problemów, które wymagają nie tylko szybkiego dostępu do danych, ale także głębokiej analizy i kreatywnego myślenia, np. w badaniach naukowych, złożonym planowaniu czy analizie strategicznej.

Agenci AI w przeglądarce: Project Mariner

Kolejną zapowiedzią z Google I/O 2025, która zmieni sposób, w jaki korzystamy z internetu, jest Project Mariner. To inicjatywa skupiająca się na stworzeniu agenta AI zintegrowanego z przeglądarką Chrome, zdolnego do automatyzacji złożonych zadań online.

Czym jest Project Mariner?

Project Mariner to zaawansowany agent sztucznej inteligencji zaprojektowany do autonomicznego działania w środowisku przeglądarki internetowej. Jego celem jest przejęcie od użytkownika żmudnych, wieloetapowych zadań, które normalnie wymagają manualnego przeklikiwania się przez strony, porównywania informacji czy wypełniania formularzy. Jest to wciąż projekt badawczy, a jego wczesne wersje mają być dostępne dla subskrybentów planu Google AI Ultra w USA.

Jak Mariner ma zautomatyzować zadania w Chrome?

Koncepcja działania Project Mariner opiera się na kilku kluczowych zdolnościach:

Obserwacja i zrozumienie strony: Mariner, działając w przeglądarce, ma "widzieć" i analizować zawartość wyświetlanych stron internetowych - tekst, obrazy, linki, przyciski, formularze.

Interpretacja celu użytkownika: Użytkownik będzie mógł w języku naturalnym określić zadanie, które chce zrealizować (np. "Znajdź mi loty do Londynu na przyszły weekend dla dwóch osób i zarezerwuj hotel blisko centrum w cenie do X").

Planowanie sekwencji działań: Na podstawie zrozumianego celu i obserwacji strony, Mariner ma samodzielnie opracować plan działania. Jakie strony odwiedzić, jakie informacje wyszukać, jakie opcje kliknąć, jakie dane wprowadzić w formularzach.

Wykonywanie zadań: Agent ma następnie realizować ten plan, nawigując po stronach, wchodząc w interakcje z elementami interfejsu (np. klikając przyciski, wybierając opcje z menu), czy wpisując dane.

Interakcja i uczenie się: W demonstracjach pokazywano, że Mariner może obsługiwać do 10 różnych zadań jednocześnie. Pojawiła się również koncepcja "Teach and Repeat", która sugeruje, że użytkownicy będą mogli "nauczyć" agenta konkretnych, powtarzalnych sekwencji działań, które ten będzie mógł potem samodzielnie odtwarzać.

Przykłady zadań, które Mariner może zautomatyzować:

Wyszukiwanie i porównywanie produktów lub usług (np. lotów, hoteli, ofert ubezpieczeniowych).

Rezerwowanie terminów (np. wizyt u lekarza, stolików w restauracjach).

Wypełnianie skomplikowanych formularzy aplikacyjnych.

Zbieranie i organizowanie informacji z różnych stron internetowych na zadany temat.

Śledzenie zmian cen lub dostępności produktów.

Generowanie Wideo z AI: Veo 3 i Narzędzie Flow

Veo 3, najnowsza odsłona modelu do generowania wideo (obecnie dostęp przez Vertex AI API), oraz Flow (obecnie dostęp tylko w USA), platforma ułatwiającą reżyserowanie i edycję materiałów stworzonych przez AI.

Możliwości Veo 3 (wideo z dźwiękiem):

Veo 3 to nowa generacja modelu video AI od Google. Co w niej takiego ekscytującego?

Natywne generowanie dźwięku: To prawdopodobnie najważniejsza innowacja. Veo 3 potrafi generować wideo wraz z dedykowaną ścieżką dźwiękową. Obejmuje to:

Efekty dźwiękowe: Dopasowane do sceny (np. szum ulicy, śpiew ptaków).

Muzykę: Podkład muzyczny zgodny z nastrojem.

Dialogi i mowę: Model ma być zdolny do generowania mowy, a nawet synchronizacji ruchu ust postaci (lip-syncing) z wygenerowanym lub dostarczonym tekstem. To duży krok naprzód w porównaniu do wcześniejszych "niemych" wideo generowanych przez AI.

Większa spójność postaci i scen: Poprawiono zdolność modelu do utrzymania spójnego wyglądu postaci i elementów otoczenia w dłuższych sekwencjach wideo i przy zmianach ujęć.

Wyższa Jakość Wideo: Model wspiera generowanie wideo w wysokiej rozdzielczości, w tym 4K.

Zaawansowane rozumienie promptów i referencji: Veo 3 ma lepiej interpretować złożone polecenia tekstowe, a także wykorzystywać obrazy referencyjne do generowania wideo w określonym stylu lub z konkretnymi elementami wizualnymi.

Kontrola nad kamerą i ujęciami: Użytkownicy mają mieć większą kontrolę nad aspektami filmowymi, takimi jak ruchy kamery, kąty ujęć czy kompozycja sceny, już na etapie generowania.

Platforma Flow - narzędzie reżyserskie:

Aby ułatwić pracę z tak zaawansowanymi modelami jak Veo 3, Google wprowadziło Flow. Jest to nowa platforma, które można opisać jako interfejs reżyserski i edycyjny dla treści wideo generowanych przez AI. Flow ma umożliwić użytkownikom:

Budowanie scenariuszy: Tworzenie bardziej złożonych narracji poprzez łączenie różnych ujęć i scen.

Edycję wygenerowanych materiałów: Modyfikowanie istniejących klipów stworzonych przez Veo, np. zmiana długości, dodawanie przejść.

Kontrolę nad elementami sceny: Użytkownicy będą mogli wpływać na wygenerowane wideo, np. zmieniając kąty kamery, dodając lub modyfikując postacie, zmieniając elementy tła czy oświetlenie.

Integrację z innymi modelami: Flow prawdopodobnie będzie integrować się nie tylko z Veo, ale także z Imagen 4 (do generowania statycznych elementów graficznych lub tekstur) oraz z modelami muzycznymi (jak Lyria) do tworzenia ścieżek dźwiękowych.

Generowanie Obrazów z AI: Imagen 4

Podczas Google I/O 2025 firma zaprezentowała również Imagen 4, najnowszą wersję swojego zaawansowanego modelu sztucznej inteligencji przeznaczonego do generowania obrazów na podstawie opisów tekstowych. Podobnie jak w przypadku innych narzędzi AI od Google, nacisk położono na zwiększenie jakości, realizmu i kontroli użytkownika nad tworzonymi grafikami.

Co nowego wnosi ulepszony model Imagen 4?

Imagen 4 wprowadza szereg ulepszeń w stosunku do swoich poprzedników, mających na celu dostarczanie jeszcze bardziej imponujących i użytecznych rezultatów:

Znacznie poprawiony fotorealizm i jakość obrazu: Google twierdzi, że Imagen 4 generuje obrazy o wyższym stopniu fotorealizmu. Ma to być widoczne w lepszym odwzorowaniu oświetlenia, cieni, głębi ostrości i ogólnej kompozycji, co sprawia, że obrazy są trudniejsze do odróżnienia od rzeczywistych fotografii.

Lepsze renderowanie drobnych detali i tekstur: Jednym z kluczowych ulepszeń jest zdolność modelu do precyzyjniejszego generowania skomplikowanych detali. Obejmuje to:

Tekstury: Lepsze odwzorowanie faktur materiałów, takich jak tkaniny, metal, drewno, a także naturalnych powierzchni jak skóra, sierść zwierząt czy krople wody.

Drobne Elementy: Większa precyzja w generowaniu małych, skomplikowanych elementów obrazu.

Ulepszone generowanie tekstu na obrazach: Wcześniejsze modele AI często miały problem z poprawnym i czytelnym umieszczaniem tekstu w generowanych obrazach. Imagen 4 ma znacznie lepiej radzić sobie z tym zadaniem, tworząc spójne i estetyczne napisy, logotypy czy inne elementy tekstowe zintegrowane z grafiką.

Wsparcie dla różnych Formatów i rozdzielczości: Imagen 4 ma oferować większą elastyczność w kwestii formatów wyjściowych, w tym generowanie obrazów w różnych proporcjach oraz w wyższych rozdzielczościach (wspominano o 2K).

Integracja z ekosystemem Google: Podobnie jak inne modele AI, Imagen 4 będzie integrowany z różnymi produktami Google, takimi jak:

Google Workspace: Umożliwiając np. generowanie ilustracji bezpośrednio w Dokumentach czy Prezentacjach.

Flow: Wspierając proces tworzenia wideo poprzez generowanie statycznych teł, postaci czy rekwizytów.

Android XR i Inteligentne Okulary

Google I/O 2025 przyniosło również istotne informacje na temat zaangażowania firmy w rozwój technologii rzeczywistości rozszerzonej (AR) i mieszanej (XR), ze szczególnym uwzględnieniem platformy Android XR oraz nowej generacji inteligentnych okularów.

Plany Google dotyczące okularów AR/XR i platformy Android XR:

Wydaje się, że Google wyciągnęło wnioski z przeszłości i podchodzi do tematu inteligentnych okularów z nową strategią, mocno opartą na integracji ze sztuczną inteligencją i współpracy z partnerami.

Platforma Android XR:

Co to jest: Android XR to platforma systemowa dedykowana urządzeniom rozszerzonej i mieszanej rzeczywistości. Ma ona stanowić fundament dla ekosystemu urządzeń i aplikacji AR/XR, podobnie jak Android dla smartfonów.

Cel: Ustandaryzowanie rozwoju aplikacji AR/XR, zapewnienie spójnego doświadczenia użytkownika oraz ułatwienie producentom sprzętu tworzenia kompatybilnych urządzeń.

Inteligentne okulary - nowe podejście:

Fokus na codzienne okulary: Zamiast masywnych headsetów VR/AR, Google wydaje się skupiać na tworzeniu inteligentnych okularów, które są lżejsze, bardziej stylowe i mogą być noszone na co dzień, podobnie jak tradycyjne okulary korekcyjne czy przeciwsłoneczne.

Partnerstwa z producentami okularów: Aby osiągnąć ten cel, Google nawiązało współpracę z uznawanymi markami okularowymi, takimi jak Gentle Monster i Warby Parker. Celem jest połączenie technologii Google z doświadczeniem tych firm w projektowaniu modnych i wygodnych opraw.

Współpraca z Samsung (Project Moohan): Strategiczna współpraca z firmą Samsung, znana pod nazwą kodową Project Moohan, która ma zaowocować nowymi urządzeniami XR. Pierwsze efekty tej współpracy mają pojawić się jeszcze w tym roku.

Kluczowa rola AI (Gemini):

Sercem nowych inteligentnych okularów ma być zaawansowana sztuczna inteligencja. Modele Gemini mają być głęboko zintegrowane z działaniem okularów.

AI ma umożliwić naturalną interakcję z okularami (głosową, być może gestami) oraz dostarczać inteligentne, kontekstowe informacje i funkcje.

Główne funkcje:

Tłumaczenie w czasie rzeczywistym: Okulary mają wyświetlać tłumaczenie rozmów lub tekstów bezpośrednio w polu widzenia użytkownika.

Nawigacja kontekstowa: Wskazówki nawigacyjne wyświetlane dyskretnie, prowadzące użytkownika do celu (podobne do HUD w samochodach).

Informacje kontekstowe: Wyświetlanie relevantnych informacji o otoczeniu, np. o mijanych obiektach, restauracjach, czy produktach (wykorzystując możliwości Project Astra).

Obsługa powiadomień i komunikacji: Możliwość odczytywania i odpowiadania na wiadomości tekstowe bez wyciągania telefonu.

Sterowanie słosem: Wykonywanie zdjęć, wyszukiwanie informacji czy uruchamianie funkcji za pomocą komend głosowych.

Teleobecność 3D: Google Beam (dawniej Project Starline)

Czym jest Google Beam?

Google Beam to zaawansowany system teleobecności (lub wideokonferencji 3D), który ma na celu stworzenie wyjątkowo realistycznego doświadczenia rozmowy wideo. W przeciwieństwie do tradycyjnych rozmów wideo, Beam generuje trójwymiarowy, naturalnej wielkości obraz osoby, z którą rozmawiamy, sprawiając wrażenie, jakby znajdowała się ona fizycznie w tym samym pomieszczeniu, siedząc naprzeciwko nas.

Google rozwija tę technologię od kilku lat, początkowo testując ją wewnętrznie i z wybranymi partnerami korporacyjnymi. Na I/O 2025 ogłoszono partnerstwo z firmą HP, która ma zająć się produkcją i komercjalizacją urządzeń wykorzystujących technologię Google Beam.

Google Beam to próba:

Przełamania barier komunikacji zdalnej: Stworzenia technologii, która faktycznie zbliża ludzi, mimo fizycznego dystansu.

Zwiększenia efektywności i jakości spotkań biznesowych: Umożliwienia bardziej angażujących i produktywnych interakcji w świecie coraz bardziej opartym na pracy zdalnej i hybrydowej.

Wyznaczenia nowego standardu w wideokonferencjach: Pokazania, jak może wyglądać przyszłość komunikacji wideo.

AI w Google Workspace (Gmail, Meet)

Google kontynuuje intensywną integrację sztucznej inteligencji ze swoim pakietem narzędzi biurowych Google Workspace. Celem jest uczynienie codziennej pracy bardziej efektywną, mniej czasochłonną i bardziej inteligentną poprzez automatyzację zadań, dostarczanie kontekstowej pomocy i ułatwianie komunikacji.

1. Gmail:

Spersonalizowane odpowiedzi:

Jak usprawni pracę: AI ma analizować historię Twoich konwersacji z danym kontaktem lub w danym wątku, aby generować sugestie odpowiedzi, które nie tylko są trafne merytorycznie, ale także dopasowane do Twojego stylu i tonu komunikacji (np. formalnego lub nieformalnego) używanego wcześniej w stosunku do tej osoby.

Sprzątanie skrzynki odbiorczej:

Jak usprawni pracę: Użytkownicy będą mogli za pomocą prostego polecenia dla Gemini (np. "Usuń wszystkie maile od firmy X z ostatniego roku") szybko oczyścić swoją skrzynkę odbiorczą z niepotrzebnych wiadomości, bez konieczności manualnego wyszukiwania i usuwania.

Sugestie planowania spotkań:

Jak usprawni pracę: Jeśli Gemini wykryje w treści maila próbę umówienia spotkania, automatycznie zaproponuje dostępne terminy w kalendarzu wszystkich uczestników (jeśli mają udostępnione kalendarze).

2. Google Meet:

Tłumaczenie mowy w czasie rzeczywistym:

Jak usprawni pracę: Ta funkcja ma działać jak osobisty tłumacz podczas spotkań online. Wypowiadane słowa będą niemal natychmiast tłumaczone na preferowany język słuchacza i wyświetlane jako napisy (lub potencjalnie odtwarzane głosowo). Ułatwi to komunikację w międzynarodowych zespołach i z klientami z zagranicy, przełamując bariery językowe. Funkcja ta ma być początkowo dostępna w wersji beta dla subskrybentów Google AI Pro i Ultra.

I. 🤔 “No dobrze Marcin… to od czego zacząć?”

Takie pytanie - w tej czy w innej formie - usłyszałem od moich znajomych na przestrzeni kilku tygodni kilka razy. Jest to niewątpliwy trend, jest to zwuważalne tąpnięcie. Pytali mnie ci, którzy wcześniej przewracali oczami na myśl o “sztucznej inteligencji”. Dziś - przepraszam za określenie - ale nieco zmiękli.

Powodów jest kilka:

Umiejętności AI zaczyznają wymagać od nich ich przełożeni

Chcą zmienić pracę i czytają wymagania w ofertach

Obserwują konkurencję, która wdraża AI

Wymagać zaczeli sami od siebie dostrzegając trend i chcą usprawnić procesy w pracy lub pomóc sobie w życiu prywatnym

Boją się o przyszłość…

Bzdury i mrzonki opowiada pół LinkedIna, który mam wrażenie twierdzi, że AI nie rozwiązuje żadnych problemów, jest bańką, sezonową ciekawostką w najgorszej narracji, a w najłagodniejszej, że jedynie pełni rolę narzędzia. Jest tam mnóstwo “ekspertów AI”, ale jeszcze więcej ich krytykujących.

I to ostanie, o narzędziu, jest oczywiście jakąś definicją, ale… tylko obowiązującą przez chwilę. AI jest dziś narzędziem - owszem, z którego możesz skorzystać, ale nie musisz, ale za chwilę będzie narzędziem które będziesz musiał używać, by na koniec dnia dowiedzieć się, że dziś nie będziesz potrzebny i możesz zostać w domu. Jeżeli twierdzisz inaczej… cóż… 🙄

Jakiej odpowiedzi udzielam więc pytany o to od czego zacząć? Od postaw - odpowiadam, choć widzę, że oczekiwania są inne, bo i potrzeby są oczywiście inne w każdej z branż. Z tym, że nie ma drogi na skróty.

Mam więc w tych ostatnich tygodniach prosty zestaw do zaoferowania właśnie dla tych, którzy dotychczas wzruszali ramionami na AI, a teraz chcą złapać trochę przystępnej wiedzy. Dziś darmowy elementarz:

Elements of AI - kurs teoretyczny z certyfikatem

Przyszłość zaczyna się dziś - kurs teoretyczny i praktyczny z certyfikatem

AI Heroes Microsoft - cykl szkoleń z różnych dziedzin z certyfikatem

Newsletter Horyzont AI - np. ten dla e-commerce, a także ten dla chcących kodować i ten z bazą tutoriali do n8n, oraz mnóstwo innych wydań, które mogłeś przegapić (przejrzyj skrzynkę mailową po haśle 🔎 horyzont)

I to wszystko. AI starter pack. Znajdź czas choćby na to, a dopiero później sięgniesz po agentów AI. Zresztą w kolejnych wydaniach newslettera będziemy odsyłać lub polecać inne kursy, również te płatne.

II. ⌨️ Kodowanie w Canva już dostępne!

Canva po zapowiedziach nowych inteligentnych funkcji na początku miesiąca, jedną z najbardziej intrygujących zapowiedzi pozostawiła zamkniętą do wczoraj.

Ale już jest! Canva sprowadza kodowanie pod strzechy. Dla przykładu można:

…i wiele więcej, bo możesz użyć dowolnego prompta, a Canva wykona lub spróbuje wykonać żądany kod.

Ja dla przykładu stworzyłem dziś jednym promptem prostą stronę www turnieju tenisowego który organizuję, i już jutro, po uzupełnieniu potrzebnych danych, będę launchował ją w internecie (Canva umożliwia tworzenie projektów stron internetowych, a nawet umożliwi Ci z poziomu narzędzia udostępnić ją publicznie).

Oczywiście kodowanie w Canvie ma swoje ograniczenia, bo to proste kodowanie. Jest sporo do poprawienia. Wprawne oko zauważy, że jest dużo powielanych elementów, brak opisów, że struktura byłaby trudna do utrzymania, gdyby chodziło o większy projekt. Ale umówmy się… to jest dopiero pierwszy krok.

Nadciąga era, gdzie Ty sam/sama, bez zaplecza developerskiego będziesz mógł tworzyć ciekawe projekty, ich Minimum Viable Product i rozwijać swoje pomysły niemal w pojedynkę.

Z pewnością jednak kodowanie z Canva to inicjacja dla wielu branż, która daje sporą wartość.

🥡 AI na Wynos - nowości AI

👦🏻 Dyrektor z Google'a ostrzega nastolatków. „Uczcie się działać z AI” - czytaj

🎓 Aż 71% osób, które ukończyły ten kurs wykorzystuje w pracy narzędzia AI - czytaj

🩺 Sztuczna inteligencja już diagnozuje, ale odpowiedzialność wciąż spada na lekarza - czytaj

🥶 Straszyła i szantażowała pracowników. Najnowsza sztuczna inteligencja Anthropic jest niezwykle potężna - czytaj

🙌🏻 Polskie AI, które automatyzuje tłumaczenie języka migowego dla osób niesłyszących - czytaj

👁 AI vs zaćma - czytaj

⚡️Zużycie energii przez AI nawet o 165 procent do 2030 roku - czytaj

🗳 Nawet 50% treści w kampanii prezydeckiej jest tworzone przez boty - czytaj

📬 Czytałeś/-aś ostatnie wydanie ze środy? Szukaj w skrzynce maila pt. tytułem:

“😎 Dlaczego warto i jak zostać liderem AI? / 📗 AI książka 💼 AI Jobs”

1. Czego nie wiesz, o PRAWIE AI? - Mikołaj Chałas

"Nvidia. Droga do sukcesu" Pierwsza biografia jednej z najważniejszych firm świata już w sprzedaży:

Niższa cena tylko do dnia premiery. To książka dla tych, którzy pragną zrozumieć gwałtowny rozwój sztucznej inteligencji i ważną rolę Nvidii w tym fenomenie.

Dzięki za przeczytanie tego wydania newslettera Horyzont AI!

- @MarcinUszyński @JakubNorkiewicz

Jeśli jesteś tu pierwszy raz - dołącz za darmo, aby regularnie otrzymywać takie treści na swojego maila.

A jeśli już jesteś subskrybentem i dotarłeś tutaj, oceń treść:

Jeżeli chcesz słuchać treści newsletterów w formie audio, to subskrybuj nasz kanał youtube - gorąco zachęcamy!